大屏语音助手作为智能助手的一种落地形态,将语音识别,语义理解,对话机器人,大屏控制结合在一起。对接大屏的后台系统后,可支持语音或文本对话的方式来操作大屏展示,语音查询数据,内容播报等功能 优势 自定义唤醒词 针对不同客户需求,定制客户个性化的唤醒词 个性化机器人语音 支持不同语速、音色的播报声音,每天都有新体验

云容器实例和云容器引擎有什么区别? 镜像、容器、工作负载的关系是什么? 如何从容器访问公网? 查看更多 即刻开启 您的 容器化上云 之旅 购买 您可能感兴趣的产品 您可能感兴趣的产品 云容器实例 CCE 提供高可靠的企业级容器应用管理服务 华为云UCS 提供无处不在的云原生服务 容器镜像服务 SWR 支持容器镜像全生命周期管理的服务

软件采购与销售:软件商城 3500+的行业应用,满足您的业务需要 应用集成发布:IoT行业生态工作台 物联网应用与云端能力的“零”代码集成,一次集成多点分发 加入华为云生态,成为合作伙伴 加入华为云IoT生态圈,实现商业共赢 展开3 收起3 解决方案 提供适用于各行业的、预集成的产品与能力的组合,以满足企业ICT业务上云的需求

华为云启动AI大赛,挑战阿尔茨海默病早期识别 虽然深度学习等人工智能算法在医学图像上的研究已取得巨大进步,但目前在脑疾病的脑影像数据上的研究和应用尚待突破,已知的学习算法对于阿尔茨海默病和轻度认知损害的区分能力还有待提升,人们仍在努力探索何种影像学指标能作为用于疾病的诊断和疗效评价的标志。 26 04月 2021

园区和城市监管范围广,采用人工巡查的方式进行相关事件的发现和处置将需要大量的人工投入,并且无法做到全方位、全时段覆盖 应急事件处置闭环慢 应急事件和突发状况的处置依赖人工操作,缺乏基于人工智能的自动化应急处置和事件分析能力,造成业务闭环过慢 场景多样化,适应性要求高 不同的园区和城市的场景存在较大差

预期等相关舆情数据的及时感知。 知识计算引擎 让政务决策“算得准”,打造精准化的政务治理 利用数据之间的关系进行业务和运营的优化,将来自政务各个角落不同来源的数据在一个全面的、可查询的语义图上链接起来,并展示关系中的相关点,让政务数据真正活起来,为自主决策、全局管控、精准服务和资

异构类实例安装支持对应监控的CES Agent(Linux) 查看更多 即将开启 GPU加速云服务器 上云之旅 开始试用 您可能感兴趣的产品 您可能感兴趣的产品 弹性云服务器 ECS 可随时自动获取、弹性伸缩的云服务器 对象存储服务 OBS 稳定、安全、高效、易用的云存储服务 虚拟私有云

多涉海行业带来显著的经济、安全和环境价值。 气象局 面向气象局领域提供高精度区域气象预测模型的训推工具链,可支持精准预报未来5天、逐小时、3公里网格的气温、降雨、风速等关键要素。为政府应急决策提供科学依据。 电力能源 面向电力能源提供高精度百米级风、光辐射模型的训推工具链,实现预

查看详情 应用案例 - 云原生开发:按需获取的开发环境,支持主流开发语言,一键部署上云; - 教学与培训:开箱即用的教学环境,支持习题下载和在线判题,大并发; CloudShell CloudShell 通过浏览器即可访问的云命令行环境,可使用内置的华为云CLI(HCloud命令)访问和

片是否符合照片标准。一.系统功能架构 1)设置管理 设置系统运行以及匹配各地区使用的必要设置。如邮件服务器、短信服务器等。 2)审核管理 主要实现报名照片的图像审核、考生信息内容审核,是整个系统的核心功能。包括:自动审核、人工审核以及审核条件设置等。 3)导出管理 主要包括导出考生审核结果和考生审核照片。

estful API的接口方式对外提供服务。本地的智能配料系统应用软件通过公网的方式调用模型,并将结果解析和保存。云计算具有高效的运算能力,在原有服务器基础上增加云计算功能能够使计算速度迅速提高,最终实现动态扩展虚拟化的层次达到对应用进行扩展的目的。结合公司的产品加工工艺及历史数

达12万元以上、或购买本产品与本公司其他硬件产品合计金额达12万元以上的用户,或者购买以上任意规格的产品达到20套以上的用户,湖北亿生为科技有限公司可提供1-2天的产品现场安装与基础培训服务;未达到此购买条件的,湖北亿生为科技有限公司可提供远程指导与协助。3.本产品支持开票服务,

高效、教师教学更加便捷、学校管理更加有序。,提供完善的人工智能教学管理平台,支持学生线上自主学习和能力拓展训练,降低对师资的依赖和教师的授课难度。,平台通过典型的算法展示,结合人工智能的应用场景与案例,对学生进行人工智能方向的综合实训,构建专业教学由点及面、实训开发由理论到应用、

在面粉加工产品加工生产过程中,希望通过人工智能算法完成面粉原料的自动配比混合的优化,以达到节省成本及提高效率的目的,实现柔性生产;不同品种不同批次的面粉有着不同的基粉指标含量。 在面粉加工产品加工生产过程中,希望通过人工智能算法完成面粉原料的自动配比混合的优化,以达到节省成本及提高效率的目的,实现

达12万元以上的用户,湖北亿生为科技有限公司可提供1-2天的产品现场安装与基础培训服务;未达到此购买金额的,湖北亿生为科技有限公司可提供远程指导与协助。3.本产品支持开票服务,商家可开增值税普通发票(税率1%)或增值税专用发票(税率3%或者税率1%),请购买此商品的客户知悉。1.国产技术、昇腾框架

达12万元以上的用户,湖北亿生为科技有限公司可提供1-2天的产品现场安装与基础培训服务;未达到此购买金额的,湖北亿生为科技有限公司可提供远程指导与协助。3.本产品支持开票服务,商家可开增值税普通发票(税率1%)或增值税专用发票(税率3%或者税率1%),请购买此商品的客户知悉。1.国产技术、昇腾框架

小车底盘、32G MICRO sd、螺丝螺母组成。所有主板和传感器拥有独立知识产权。,拼接式的使用方法,扩展性强,适合创客教学。,独特的RJ25接口、适合大班上课。,适配所有主流的人工智能创新挑战赛。

式AI和大模型的基础概念、关键技术和行业应用,以支持生成式AI和大模型的战略方向把握和决策。 课程内容:讲解生成式AI的概念、现状、趋势和市场洞察;讲解大语言模型的概念,ChatGPT的演进过程、优势、局限性和应用场景,解析ChatGPT强大能力的本质,分析其未来的演进方向,论证

用户创建Notebook时所选用的镜像是经过多次保存的自定义镜像或用户自行注册的镜像,基于该镜像所创建的Notebook已经无法再执行镜像保存的操作了。 解决方法 使用公共镜像或其他的自定义镜像来创建Notebook,完成镜像保存操作。 ModelArts-产品相关介绍 更快的普惠AI平台 ModelArts产品文档

的实时监控和分析,以及生产计划的优化和调整。又壹MES的服务特点包括:高度定制化、灵活可扩展、易于集成、可靠稳定。他们的团队拥有丰富的行业经验和技术实力,能够根据客户的需求和现有的生产环境,提供量身定制的解决方案。他们的系统可以根据企业的需求进行灵活的扩展和定制,以适应不同规模和

基于深度学习算法的语音识别 使用MindSpore进行可视化调试调优 基于昇腾AI处理器的算子开发 基于昇腾AI处理器的目标检测应用(ACL) 基于深度学习算法的语音识别 使用MindSpore进行可视化调试调优 基于昇腾AI处理器的算子开发 基于昇腾AI处理器的目标检测应用(ACL)

基于深度学习算法的语音识别 使用MindSpore进行可视化调试调优 基于昇腾AI处理器的算子开发 基于昇腾AI处理器的目标检测应用(ACL) 基于深度学习算法的语音识别 使用MindSpore进行可视化调试调优 基于昇腾AI处理器的算子开发 基于昇腾AI处理器的目标检测应用(ACL)

助您安全的控制华为云资源的访问。 如果华为云账号已经能满足您的要求,不需要创建独立的IAM用户进行权限管理,您可以跳过本章节,不影响您使用GaussDB服务的其它功能。 通过IAM,您可以在华为云账号中给员工创建IAM用户,并授权控制他们对华为云资源的访问范围。例如您的员工中有负

等高危操作的权限,那么您可以使用IAM为开发人员创建用户,通过授予仅能使用GaussDB,但是不允许删除GaussDB的权限,控制他们对GaussDB资源的使用范围。 IAM是华为云提供权限管理的基础服务,无需付费即可使用,您只需要为您账号中的资源进行付费。关于IAM的详细介绍,请参见IAM产品介绍。

角色:IAM最初提供的一种根据用户的工作职能定义权限的粗粒度授权机制。该机制以服务为粒度,提供有限的服务相关角色用于授权 IAM最新提供的一种细粒度授权的能力,可以精确到具体服务的操作、资源以及请求条件等。基于策略的授权是一种更加灵活的授权方式,能够满足企业对权限最小化的安全管控要求。

打不开邮箱网页主要有如下原因:1、您本地的网络到我们邮局服务器网络不通。2、如果网址是您绑定自己的域名,有可能是您的域名解析没有生效。3、如果网址是您绑定自己的域名,也有可能是您本地DNS到域名提供商的DNS服务器网络不通。您可以在自己电脑中用CMD命令进入命令行模式,然后运行ping 您的域名,将结果反馈给我们。

成本效益高 成功降低了生产成本,这款商品的性价比极高。客户可以以较低的价格获得高质量的商品,获得更高满意度。 成功降低了生产成本,这款商品的性价比极高。客户可以以较低的价格获得高质量的商品,获得更高满意度。 RPA优势 达观数据流程自动化机器人平台软件 产品介绍 达观数据流程自动化机器

人工智能的定义

MaaS提供了基于昇腾云算力适配的开源大模型(DeepSeek、通义千问等),您可以使用这些基础模型,结合自定义的模型权重文件(权重类文件、词表类文件和配置类文件),创建个人专属的模型。创建成功的模型可以进行调优、推理等操作。

操作场景

在当今数字化时代,人工智能应用愈发广泛。许多开发者和研究人员期望拥有个性化的大模型,用于各种特定场景,例如开发智能客服提升服务效率、辅助代码写作等。通常情况下,从头训练一个大模型需要大量的时间、计算资源和资金。多数开发者难以承担从头训练大模型的高昂成本,且技术门槛极高,涉及复杂的算法优化、海量数据处理等难题。

即使选择对开源模型进行微调,实际操作过程中仍存在阻碍,例如模型权重文件格式兼容性问题频发、本地训练的PyTorch权重文件与云平台不兼容,导致模型无法加载、不同模型的参数配置差异大等。

MaaS基于昇腾云算力适配开源大模型,推出预置模型+自定义权重的全流程方案:

- 极简操作,快速适配:支持直接上传Hugging Face标准格式的权重文件,平台自动完成与昇腾芯片的算力适配,无需编写额外适配代码。

- 模板化配置,即开即用:内置DeepSeek、通义千问、百川、ChatGLM、Llama等主流模型的配置模板,用户无需手动调整复杂参数,大幅缩短模型开发周期。

- 弹性算力,高效运行:提供灵活的算力资源按需分配机制,可根据模型规模和业务需求动态调整算力,为业务高效运行提供强大保障。

为什么要创建我的模型

MaaS模型广场提供了丰富的基础模型,您可以直接使用这些模型进行在线体验、部署模型服务等操作。当基础模型无法满足个性化需求时,您可以基于模型广场的模型创建专属的个性化模型,以实现更优的效果,同时便于版本管理和持续优化。

- 满足个性化需求:MaaS支持结合自定义权重文件,基于昇腾云适配的开源模型创建个人专属模型。模型广场预置模型是通用的,难以契合所有用户的特定需求,如企业需要将大模型应用于特定业务场景,预置模型因缺乏针对性难以满足需求,自定义模型可以凭借定制化权重文件实现个性化功能。

- 实现更好的效果:在某些复杂场景中,模型广场预置模型的表现可能不尽人意。例如在专业领域的对话问答、代码生成等场景,通过创建个人模型并修改权重配置,能优化模型运行效果,在专业任务处理上比预置模型更具优势。

- 便于版本管理和优化:MaaS提供模型版本管理功能,一个模型最多可支持创建10个版本。创建个人模型后,您可以通过新增版本不断优化模型,提升可追溯性。

计费说明

创建模型本身不收费,但使用过程中涉及的 OBS 存储、计算等资源会产生费用,详情请参见ModelArts Studio(MaaS)模型推理计费项。

约束限制

- 模型权重文件夹下包括权重类文件、词表类文件和配置类文件。

- 可以使用transformers的from_pretrained方法对模型权重文件夹进行加载。

前提条件

已注册华为账号并开通华为云,详情请见注册华为账号并开通华为云。

步骤一:准备权重配置文件

如果Hugging Face网站打不开,请在互联网上搜索解决方案。

(可选)步骤二:修改权重配置文件

当选择ChatGLM3-6B、GLM-4-9B、Qwen-7B、Qwen-14B、Qwen-72B、Baichuan2-7B、Baichuan2-13B、Llama2-7B、Llama2-13B和Llama2-80B基础模型(名字必须一致)创建模型时,建议对权重配置参数进行优化调整,以提升模型的预测精度和输出质量,从而构建更贴合具体业务需求的定制化模型。修改后的权重文件要更新至OBS桶中。

Qwen2.5系列模型无需修改权重即可部署。关于如何部署模型服务,请参见使用ModelArts Studio(MaaS)部署模型服务。

- ChatGLM3-6B、GLM-4-9B

修改文件“tokenization_chatglm.py”。

- 第一处

# Load from model defaults assert self.padding_side == "left"

修改为

# Load from model defaults # assert self.padding_side == "left"

- 第二处

if needs_to_be_padded: difference = max_length - len(required_input) if "attention_mask" in encoded_inputs: encoded_inputs["attention_mask"] = [0] * difference + encoded_inputs["attention_mask"] if "position_ids" in encoded_inputs: encoded_inputs["position_ids"] = [0] * difference + encoded_inputs["position_ids"] encoded_inputs[self.model_input_names[0]] = [self.pad_token_id] * difference + required_input

修改为

if needs_to_be_padded: difference = max_length - len(required_input) if "attention_mask" in encoded_inputs: encoded_inputs["attention_mask"] = encoded_inputs["attention_mask"] + [0] * difference if "position_ids" in encoded_inputs: encoded_inputs["position_ids"] = encoded_inputs["position_ids"] + [0] * difference encoded_inputs[self.model_input_names[0]] = required_input + [self.pad_token_id] * difference

- 第一处

- Qwen-7B、Qwen-14B和Qwen-72B

- 第一处,修改文件“modeling_qwen.py”。

原内容

SUPPORT_BF16 = SUPPORT_CUDA and torch.cuda.is_bf16_supported() SUPPORT_FP16 = SUPPORT_CUDA and torch.cuda.get_device_capability(0)[0] >= 7

修改为

SUPPORT_BF16 = SUPPORT_CUDA and True SUPPORT_FP16 = SUPPORT_CUDA and True

- 第二处,修改文件“tokenizer_config.json”。

在文件中增加内容

chat_template = {% for message in messages %}{{'<|im_start|>' + message['role'] + '\n' + message['content']}}{% if (loop.last and add_generation_prompt) or not loop.last %}{{ '<|im_end|>' + '\n'}}{% endif %}{% endfor %}{% if add_generation_prompt and messages[-1]['role'] != 'assistant' %}{{ '<|im_start|>assistant\n' }}{% endif %}

- 第一处,修改文件“modeling_qwen.py”。

- Baichuan2-7B和Baichuan2-13B

在文件“tokenizer_config.json”中增加如下内容。

chat_template = {% for message in messages %}{{'<|im_start|>' + message['role'] + '\n' + message['content']}}{% if (loop.last and add_generation_prompt) or not loop.last %}{{ '<|im_end|>' + '\n'}}{% endif %}{% endfor %}{% if add_generation_prompt and messages[-1]['role'] != 'assistant' %}{{ '<|im_start|>assistant\n' }}{% endif %} - Llama2-7B、Llama2-13B和Llama2-80B

在文件“tokenizer_config.json”中增加如下内容。

chat_template = {% if messages[0]['role'] == 'system' %}{% set loop_messages = messages[1:] %}{% set system_message = messages[0]['content'] %}{% else %}{% set loop_messages = messages %}{% set system_message = false %}{% endif %}{% for message in loop_messages %}{% if (message['role'] == 'user') != (loop.index0 % 2 == 0) %}{{ raise_exception('Conversation roles must alternate user/assistant/user/assistant/...') }}{% endif %}{% if loop.index0 == 0 and system_message != false %}{% set content = '<<SYS>>\\n' + system_message + '\\n<</SYS>>\\n\\n' + message['content'] %}{% else %}{% set content = message['content'] %}{% endif %}{% if message['role'] == 'user' %}{{ bos_token + '[INST] ' + content.strip() + ' [/INST]' }}{% elif message['role'] == 'assistant' %}{{ ' ' + content.strip() + ' ' + eos_token }}{% endif %}{% endfor %}

步骤三:将权重配置文件上传至OBS桶

关于如何将权重文件存储到OBS桶,请参见上传概述。

单次上传本地文件到OBS的总大小不能超过5GB。如果需要上传超过5GB的大对象,可以使用OBS Browser+、obsutil工具上传,或使用OBS SDK及API的多段接口上传,上限为48.8TB,详情请参见如何上传超过5GB的大对象。

步骤四:创建我的模型

- 登录ModelArts Studio(MaaS)控制台,在顶部导航栏中选择目标区域。

- 在左侧导航栏,单击“我的模型”。

- 在“我的模型”页面右上角,单击“创建模型”。

- 在“创建模型”页面,配置相关参数。

表1 创建模型参数说明 参数

说明

来源模型

MaaS提供基于昇腾云算力适配的开源大模型供您使用。单击“选择基础模型”,在弹窗中选择模型,单击“确定”。

关于模型系列的详细介绍,请参见在ModelArts Studio(MaaS)模型广场查看预置模型。

模型名称

自定义模型名称。支持1~64位,以中文、大小写字母开头,只包含中文、大小写字母、数字、下划线(_)、中划线(-)和(.)。

描述

自定义模型简介。最大支持100字符。

权重设置与词表

默认选择“自定义权重”。权重文件指的是模型的参数集合。

自定义权重存储路径

单击“自定义权重存储路径”右侧的文件图标,选择步骤三存放模型权重文件的OBS路径(必须选择到模型文件夹),然后单击“确定”。

- 参数配置完成后,单击“创建”,创建自定义模型。

在模型列表,当模型“状态”变成“创建成功”时,表示模型创建完成。

步骤五:查看我的模型详情

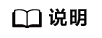

模型创建完成后,您可以在“模型详情”页面查看模型的基本信息和版本信息。

在“我的模型”页面,单击目标模型名称,进入模型详情页面,查看模型的“基本信息”和“我的版本”。

- 基本信息:可以查看模型名称、模型ID、模型类型、来源模型、创建时间等信息。

- 我的版本:可以查看已创建的模型版本,单击版本号进入“版本详情”页面,可以查看各个模型版本的详细信息和任务记录。

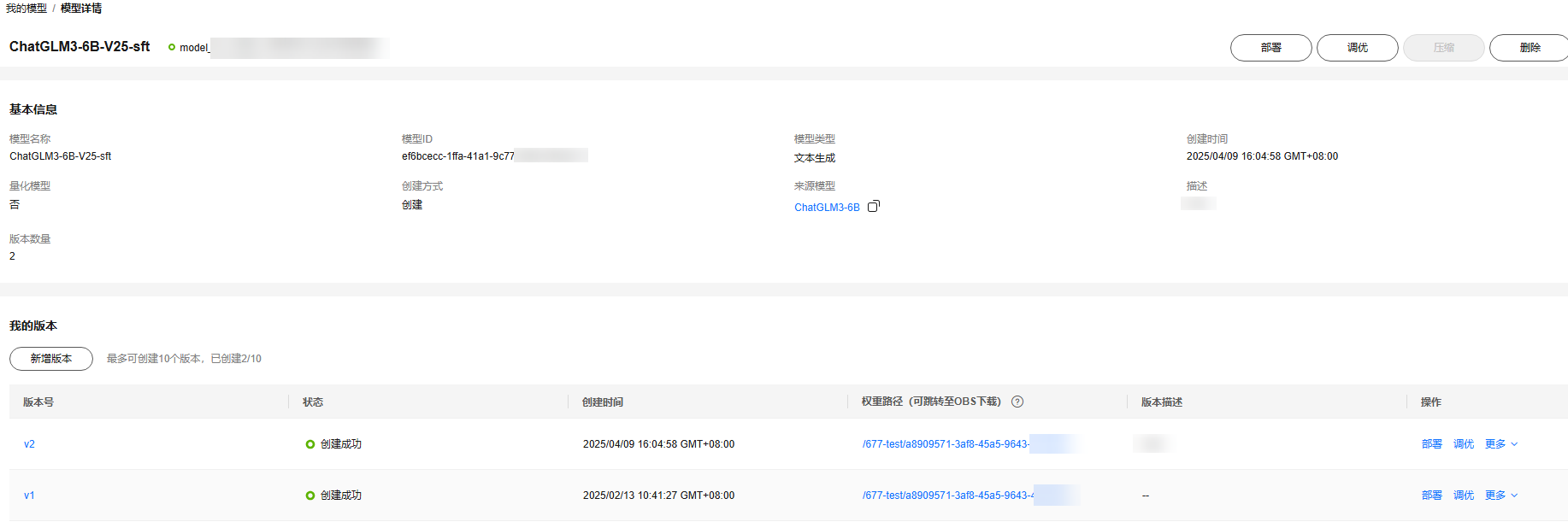

图2 版本详情

- 版本信息:可以查看模型名称、状态、创建时间、基本模型及版本、权重与词表路径等信息。

- 任务记录:可以查看任务名称、作业类型、状态、创建时间等信息。

(可选)步骤六:新增模型版本

为了提升模型的可追溯性和优化效率,MaaS提供了模型版本管理功能。通过此功能,您能够创建模型的新版本。一个模型最多支持创建10个版本。

- 在ModelArts Studio(MaaS)控制台左侧导航栏,单击“我的模型”进入模型列表。

- 单击目标模型名称,进入模型详情页面。

- 在“我的版本”区域,单击“新增版本”。

- 在“新增版本”页面,配置模型新版本的参数。

表2 新增模型版本参数说明 参数

说明

新版本号

系统自动编号,不可修改。

版本描述

自定义模型版本简介。最大支持100字符。

选择基础模型版本

选择基础模型的版本。

选择权重路径

单击文件图标,选择步骤三存放模型权重文件的OBS路径(必须选择到模型文件夹),然后单击“确定”。

- 配置完成后,单击“确定”,新增模型版本。

在版本列表,当新增版本的“状态”变成“创建成功”时,表示模型新版本创建完成。

(可选)步骤七:删除我的模型

当不需要模型时,可以进行删除操作。删除操作无法恢复,请谨慎操作。

- 在ModelArts Studio(MaaS)控制台左侧导航栏,选择“我的模型”进入模型列表。

- 在模型列表,单击目标模型名称,进入“模型详情”页面。

- 在“我的版本”区域,单击版本号,进入“版本详情”页面。查看该版本的模型“任务记录”是否为空。

- 确认该模型的各个版本的“任务记录”都为空。

当模型存在任务记录会删除失败。

- 在“模型详情”页面,单击右上角的“删除”,在弹窗中输入“DELETE”,单击“确定”,删除模型。

当模型列表未显示该模型,表示删除成功。

后续操作

- 当模型创建成功后,您可以对模型进行调优,获得更合适的模型。具体操作,请参见使用ModelArts Studio(MaaS)调优模型。

- 您可以将创建成功的模型进行部署,并调用模型服务。具体操作,请参见调用ModelArts Studio(MaaS)部署的模型服务。

常见问题

创建模型时,报错“Modelarts.6206:Key fields describing the model structure are missing from config.json, or their values are inconsistent with standard open source”如何处理?

您可以按照以下步骤进行排查:

- 查看config.json文件是否存在。

- 查看config.json文件格式是否符合要求。关于格式要求,请参见Hugging Face官网。

人工智能的定义常见问题

更多常见问题 >>-

SFS的常见问题解答。

-

灰度发布的定义与流程介绍。

-

远程办公分为两个部分:“远程”和“办公”,这是指通过互联网技术实现的非本地办公:远程办公模式,例如家庭办公,远程办公和移动办公。它主要是通过一些第三方远程控制软件(例如welink)来实现的,以实现办公室和公司的电话会议,并实现远程办公室的目的。

-

云原生的业界定义和代表技术介绍。

-

云计算作为近年被热炒的概念,Google、Amazon、IBM等IT巨头们也以前所未有的速度和规模推动着其技术和产品的普及,那么究竟什么是云计算呢?

-

弹性负载均衡(Elastic Load Balance,简称ELB)是将访问流量根据分配策略分发到后端多台服务器的流量分发控制服务。弹性负载均衡可以通过流量分发扩展应用系统对外的服务能力,同时通过消除单点故障提升应用系统的可用性。

更多相关专题

增值电信业务经营许可证:B1.B2-20200593 | 域名注册服务机构许可:黔D3-20230001 | 代理域名注册服务机构:新网、西数