DeepSeek-V3 DeepSeek-R1模型部署 大模型训练方案-

| 版本: -- | 交付方式: 人工服务 |

| 适用于: | 上架日期: 2025-05-08 06:57:35 |

1.咨询版 主要为用户提供关于DeepSeek-V3和DeepSeek-R1模型训练的专业咨询服务,内容包括:

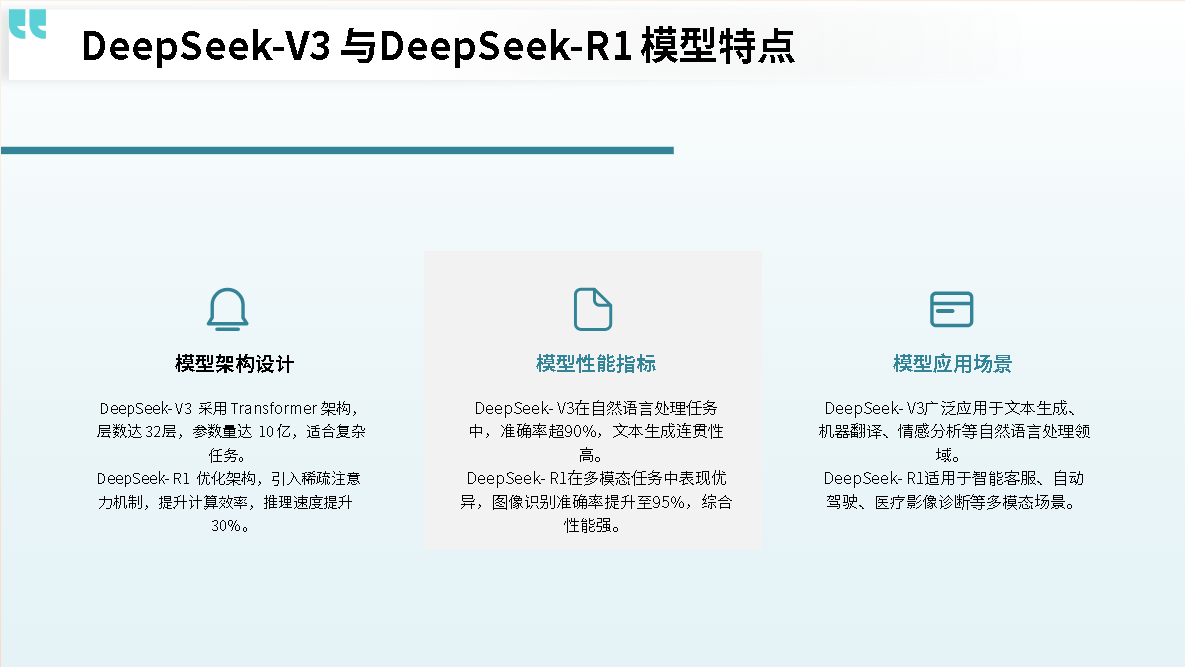

模型特性分析:详细介绍DeepSeek-V3和DeepSeek-R1模型的架构特点、适用场景以及性能优势。例如,DeepSeek-V3擅长通用自然语言处理任务,而DeepSeek-R1在逻辑推理、数学和编程任务上表现更优。

训练方案定制:根据用户的具体需求,提供定制化的训练方案,包括数据准备、训练策略选择、优化技术应用等。例如,采用混合精度优化技术,以降低训练成本。

技术咨询与支持:解答用户在模型训练过程中可能遇到的技术问题,提供专业的建议和解决方案。

2.标准版

标准版是针对DeepSeek-V3和DeepSeek-R1模型的标准化部署方案,旨在为用户提供快速、高效且易于操作的模型部署服务。该版本适合希望在短时间内将模型投入生产环境的用户,同时兼顾了成本效益和性能优化。

核心特点

一键部署:通过标准化的部署流程,用户可以通过简单的操作完成模型的部署。无论是单机部署还是云端部署,都能通过预设的配置快速启动。

优化的硬件适配:标准版针对常见的硬件环境进行了优化,确保在不同配置的服务器或云资源上都能高效运行。例如,DeepSeek-V3和DeepSeek-R1模型支持多种量化版本(如4bit、8bit量化),以适应不同显存容量的设备。

成本效益:标准版在保证性能的同时,通过优化的资源分配和量化技术,降低了部署成本。用户可以根据实际需求选择合适的部署方案,避免资源浪费。

易于集成:提供标准化的API接口和文档,方便用户将模型集成到现有的应用系统中。无论是开发聊天机器人、内容生成工具还是其他自然语言处理应用,都能快速实现功能对接。

部署流程

选择部署环境:

本地部署:用户可以在本地服务器上部署模型,适合对 数据安全 性和隐私性要求较高的场景。

云端部署:支持主流云平台(如阿里云、AWS、Azure等),用户可以根据需求选择合适的云资源。

配置模型参数:

选择模型版本:用户可以根据需求选择DeepSeek-V3或DeepSeek-R1模型,以及对应的量化版本。

设置资源参数:根据硬件配置选择合适的GPU数量和显存容量。

启动服务:

一键启动:通过预设的脚本或平台工具,快速启动模型服务。

获取调用信息:部署完成后,用户将获得模型服务的Endpoint和Token,用于后续的应用调用。

性能测试:

推理测试:通过标准化的测试脚本,验证模型的推理性能,确保其符合预期。

负载测试:评估模型在高并发场景下的性能表现,优化资源配置。

3.DeepSeek-V3 DeepSeek-R1模型部署版

商品概述

DeepSeek-V3 DeepSeek-R1模型部署版是一个专门为用户提供高效、便捷的模型部署解决方案。它旨在帮助用户快速将DeepSeek-V3和DeepSeek-R1模型应用于实际业务场景中,无论是本地服务器还是云端环境,都能实现快速启动和稳定运行。

核心特点

一键部署:提供简化的部署流程,用户可以通过预设的脚本或平台工具,快速完成模型的下载、配置和启动。

多环境支持:支持多种部署环境,包括本地服务器、云平台(如阿里云、AWS、Azure等)以及容器化部署(如Docker、Kubernetes)。

性能优化:针对不同硬件配置进行了优化,支持多种量化版本(如4bit、8bit量化),以适应不同显存容量的设备,同时确保推理性能。

易于集成:提供标准化的API接口和详细的开发文档,方便用户将模型集成到现有的应用系统中,快速实现功能对接。

成本效益:通过优化的资源分配和量化技术,降低了部署成本,同时提供了灵活的计费模式,用户可以根据实际需求选择合适的方案。

部署流程

选择部署环境:

本地服务器:用户可以在本地服务器上部署模型,适合对数据安全性和隐私性要求较高的场景。

云平台:支持主流云平台,用户可以根据需求选择合适的云资源。

容器化部署:通过Docker或Kubernetes进行部署,适合需要高可扩展性和灵活性的场景。

配置模型参数:

选择模型版本:用户可以根据需求选择DeepSeek-V3或DeepSeek-R1模型,以及对应的量化版本。

设置资源参数:根据硬件配置选择合适的GPU数量和显存容量。

配置API接口:根据实际需求配置模型的API接口,确保与现有系统兼容。

启动服务:

一键启动:通过预设的脚本或平台工具,快速启动模型服务。

获取调用信息:部署完成后,用户将获得模型服务的Endpoint和Token,用于后续的应用调用。

性能测试:

推理测试:通过标准化的测试脚本,验证模型的推理性能,确保其符合预期。

负载测试:评估模型在高并发场景下的性能表现,优化资源配置。

监控与维护:

实时监控:提供实时监控功能,帮助用户随时了解模型的运行状态。

自动更新:支持模型的自动更新功能,确保用户始终使用最新版本的模型。

适用场景

企业级应用:适用于需要快速将模型应用于实际业务的企业,如 智能客服 、内容生成、数据分析等。

中小企业:为资源有限的中小企业提供成本效益高的部署方案,能够快速将模型应用于实际业务。

教育和研究机构:为学术研究和教学提供标准化的模型部署方案,方便研究人员和学生快速上手。

开发团队:适合需要快速验证模型效果的开发团队,快速搭建原型系统。

优势总结

高效部署:标准化流程确保快速部署,减少复杂配置。

性能优化:通过量化和资源优化,降低硬件和运营成本。

易于集成:提供标准化接口,方便与现有系统对接。

多环境支持:支持多种部署环境,满足不同用户的需求。

技术支持:提供详细的文档和常见问题解答,帮助用户快速解决问题。

服务与支持

技术支持:提供7×24小时的技术支持服务,帮助用户解决部署和使用过程中遇到的问题。

培训服务:提供模型使用和部署的培训服务,帮助用户快速掌握模型的应用方法。

定制服务:根据用户需求,提供定制化的部署方案和技术支持。

4.AI大模型训练方案

商品概述

AI大模型训练方案是一项为用户提供从模型选择、数据准备到训练优化的全方位服务。它旨在帮助企业和开发者高效地训练和优化大语言模型(LLM),以满足特定业务需求或研究目标。本方案适用于需要从零开始训练模型,或对现有模型进行微调的用户。

核心服务内容

模型选择与定制:

提供多种预训练模型选择,如LLaMA、Qwen等,并支持根据用户需求进行模型架构调整。

支持模型扩展,例如扩充词表以提升对特定语言(如中文)的处理能力。

数据准备与处理:

提供数据清洗、标注和增强服务,确保数据质量。

支持多模态数据处理,例如整合文本、图像等不同模态的数据。

训练流程设计:

提供从预训练到微调的全流程设计,包括监督微调(SFT)、直接偏好优化(DPO)等。

支持多种训练策略,如LoRA(低秩适应)技术,以减少训练资源需求。

优化与调优:

提供学习率调度器(如StepLR)以动态调整学习率,确保模型稳定收敛。

支持8-bit优化等技术,降低计算资源消耗。

模型评估与迭代:

提供模型性能评估服务,包括准确率、泛化能力等指标。

根据评估结果,提供模型迭代优化建议。

服务优势

高效训练:通过优化的训练流程和分布式计算技术,大幅缩短训练时间。

成本节约:采用LoRA等技术,减少训练所需的计算资源。

定制化服务:根据用户需求提供定制化的模型训练方案。

技术支持:提供7×24小时的技术支持,帮助用户解决训练过程中的问题。

适用场景

企业级应用:适用于需要训练专属大模型的企业,如金融、医疗、教育等领域。

研究机构:为学术研究提供从模型训练到优化的完整支持。

开发者:帮助开发者快速上手大模型训练,提升开发效率。

服务与支持

专家咨询:提供大模型建设咨询服务,帮助用户选择合适的模型和训练方案。

实战培训:提供大模型训练调优与应用实战培训,提升团队能力。

效果运营:模型上线后,提供基于线上数据分析的优化服务。