盘古大模型 盘古大模型 盘古大模型 PanguLargeModels 盘古大模型 PanguLargeModels 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构

了解详情 湘钢人工智能大模型价值评估报告 了解详情 大模型混合云十大创新技术 了解详情 矿山产业集群大模型运营最佳实践 了解详情 矿山大模型最佳实践白皮书 了解详情 政企AI平台架构及应用实践 湘钢人工智能大模型价值评估报告 大模型混合云十大创新技术 了解详情 矿山产业集群大模型运营最佳实践

文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古预测大模型能力与规格 盘古大模型快速入门 如何调用盘古大模型API 查看全部 AI Gallery百模千态社区 AI Gallery百模千态社区 优质昇腾云AI模型专区 几行代码自由部署AI应用 丰富多样的AI训练数据集 场景化AI案例,助力AI赋能千行百业

盘古大模型 盘古大模型 盘古NLP大模型 盘古NLP大模型 优秀的模型结构,完善的工程化能力,最贴合行业落地的NLP大模型 超大参数规模,最贴合行业落地的NLP大模型 重磅发布盘古NLP 718B深度思考模型,多专家+大稀疏比的MOE新架构,昇腾亲和设计,高效训推 专家咨询 ModelArts

广汽借助华为云盘古多模态大模型,打造业界首个支持点云生成的大模型,为其端到端仿真高效迭代提供强有力支撑。 文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古多模态大模型能力与规格 用户指南 如何调用盘古大模型API 查看全部 AI Gallery百模千态社区 AI Gallery百模千态社区

盘古大模型 盘古大模型 盘古科学计算大模型 盘古科学计算大模型 科学计算大模型致力于将人工智能与科学研究深度融合,为气象、生物医药、化学材料等前沿领域打造高精度模型,助力科研突破,赋能产业升级与创新发展。 科学计算大模型致力于将人工智能与科学研究深度融合,为气象、生物医药、化学材

学习资源 学习资源 AI开发基本流程介绍 自动学习简介 使用预置算法构建模型 使用自定义算法构建模型 查看更多 您感兴趣的产品 您感兴趣的产品 盘古NLP大模型 最贴合行业落地的NLP大模型 盘古CV大模型 赋能行业客户使用少量数据微调即可满足特定场景任务 盘古预测大模型 基于Triplet

大模型混合云TOP N 场景 大模型混合云TOP N 场景 1对1咨询 了解华为云Stack 大模型行业场景落地三要素 大模型行业场景落地三要素 场景是大模型行业落地的关键所在,而在场景落地过程中,数据、经验和生态是核心要素,数据的数量和质量决定模型效果上限;经验就像“名师指导”

大模型安全护栏 ModelArts Guard 大模型安全护栏 ModelArts Guard 大模型安全护栏(ModelArts Guard),做配套大模型的内容安全防线 大模型安全护栏(ModelArts Guard),做配套大模型的安全防线,开放兼容,适用盘古大模型和三方大模型

《互联网信息服务算法推荐管理规定》明确,具有舆论属性或者社会动员能力的算法推荐服务提供者应当在提供服务之日起十个工作日内通过互联网信息服务算法备案系统填报服务提供者的名称、服务形式、应用领域、算法类型、算法自评估报告、拟公示内容等信息 方便

湘江鲲鹏目前在人工智能大模型领域拥有算力、数据、算法三大关键要素的经验积累,构建了大模型三个方面的差异化竞争力,盘古大模型AI专业服务覆盖从前期咨询、规划设计,到数据工程、模型训练,再到应用工程及模型运维的完整流程。基于华为盘古提供的AI专业服务包,致力于为企业提供一站式人工智能解决方案

公司集成了世界领先的底层大模型,具备打通跨模型和工具链的平台,提供从需求分析、数据收集、模型设计、训练优化、评估、系统集成、用户界面设计、部署维护、合规性检查、技术支持、性能监控、扩展性设计、定制服务到持续研发一站式AI大模型定制研发服务。光启慧语是一家围绕大模型全栈开展技术研发和产

angChain等流行的大模型开发框架,构建企业级AI应用;团队拥有成熟的软件工程技术和管理能力。6. 大模型使用的技术支持,用户使用大模型平台,解答用户使用过程遇到的问题;大模型与应用对接集成,以及进行日常巡检、故障处理、模型升级等服务。4. 工业数据模型(CAD模型、CAE模

太杉天尊大模型AIGC场景解决方案是以AI场景解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。具备自研的行业模型能力,主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。太杉天尊大模型AIGC场景解决方案,是一款专为满足政府企

100%包通过,不通过,全额退款,全国可办理!生成式人工智能备案,大模型备案

数据质量。4. 模型训练:设计调优方案,实施模型训练,并进行模型评测。熟悉盘古大模型工作流和云服务操作,确保模型效果优化。5. 应用工程:提供基于大模型能力的Agent开发和应用对接服务。具备良好的软件开发和沟通能力,实现大模型与应用的无缝对接。6. 模型运维: 提供技

. 模型更新后,将新模型部署至相应环境。 十一、模型评测1. 设计模型评测方案,对大模型各类指标进行评测。2. 能够按评测标准对大模型各项能力进行打分,输出大模型评测报告。 十二、Agent开发1. 基于场景,设计并开发Agent工具。2. 基于langchain等大模型框架,完

天尊大模型AIGC场景解决方案配套服务是太杉AIGC解决方案的人工服务,是以AI应用解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。天尊大模型AIGC场景解决方案配套服务是太

华为云盘古大模型 华为云盘古大模型 AI for Industries 大模型重塑千行百业 AI for Industries 大模型重塑千行百业 盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合

免费AI客服电话-云蝠智能AI客户联络中心 免费AI客服电话-云蝠智能AI客户联络中心 “云蝠智能”企业提供AI客户联络中心,包含智能语音电话机器人、智能语音呼叫、短信分发及企业微信SCRM的业务体系。通过提供AI会员回访、通知、精准营销的系统进行产品服务和赋能。 “云蝠智能”企

Recognition,简称OCR)指将图片、扫描件或PDF、OFD文档中的打印字符进行检测识别成可编辑的文本格式。 OCR以开放API(Application Programming Interface,应用程序编程接口)的方式提供给用户,用户使用Python、Java等编程语言调用OCR服务API将图片识别

入镜像创建AI为应用。 帮助文档 收起 展开 本地准备模型包 收起 展开 在本地准备模型包,编写模型配置文件和模型推理代码,将准备好的模型包上传至对象存储服务OBS,从OBS导入模型创建为AI应用。 帮助文档 收起 展开 AI Gellary订阅模型 收起 展开 在AI Gall

r。 创建训练作业时提示“对象目录大小/数量超过限制”,如何解决? 问题分析 创建训练作业选择的代码目录有大小和文件个数限制。 解决方法 将代码目录中除代码以外的文件删除或存放到其他目录,保证代码目录大小不超过128MB,文件个数不超过4096个。 训练作业的“/cache”目录是否安全?

遵循如下规范: ·如果在连接中设置了GUC参数,那么在将连接归还连接池之前,必须使用“SET SESSION AUTHORIZATION DEFAULT;RESET ALL;”将连接的状态清空。 ·如果使用了临时表,那么在将连接归还连接池之前,必须将临时表删除。 否则,连接池里面

华为云提供免费的备案服务。 备案网站 云解析服务 将域名转换为网站服务器IP地址,实现通过域名直接访问网站。 华为云提供免费的域名解析服务。 配置网站解析 SSL证书管理 如果想要实现网站的可信身份认证与安全数据传输,您可以通过华为云SCM购买并部署SSL证书。 部署成功后,可以将HTTP协议替换成HTTPS协议,通过https://www

【限时特惠】研发与中间件专场 研发与中间件专场 众多AI创新者反馈,构建AIGC应用时常遇这些挑战 众多AI创新者反馈,构建AIGC应用时常遇这些挑战 模型开发/定制门槛高 大模型应用是一个模型、数据、代码集成的新型应用。 开发一个完整的大模型应用既需要利用多样化的AI原生技术又需要强大的工程能力,并将它们充分整合,开发门槛高

这些DeepSeek模型在多项能力上与OpenAI的o1-mini相当,为开发者提供了强大的AI能力。 在MaaS平台上,DeepSeek-R1蒸馏模型已经部署上线,开发者可以通过在线体验或API调用来使用这些模型。为了帮助开发者快速验证和开发创新的AI应用,平台还提供了200

ai智能文本校对大模型将到来

搜索大模型插件通过模型服务将AI能力集成到Elasticsearch集群中,实现语义向量搜索、语义排序等高级功能。其核心流程是基于业务需求(如语义搜索、智能推荐)定义模型类型(Embedding/Rerank等),并绑定对应的AI服务地址,确保上层应用能通过向量索引正确调用服务接口。

- 语义搜索:依赖Embedding模型服务,将文本转换为向量,实现相似性检索。

- 智能推荐:组合使用Embedding模型服务(生成用户/物品向量)和Rerank模型服务,优化推荐结果排序。

前提条件

确认Elasticsearch集群已启用搜索大模型插件,操作指导请参见开启搜索大模型插件。

支持的模型服务

搜索大模型插件支持接入多种模型服务,具体支持的模型服务清单如表1 支持的模型服务所示。

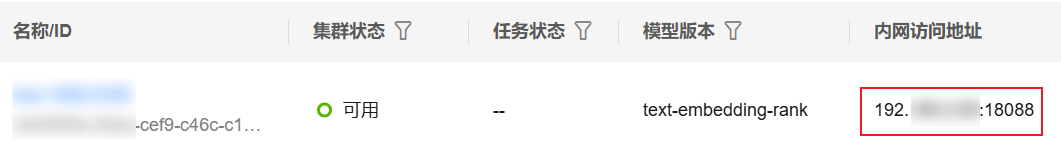

获取独享版集群的访问地址

- 登录 云搜索服务 管理控制台。

- 在左侧导航栏,选择“搜索大模型 > 独享版集群”。

- 在集群列表,选择目标集群,在“内网访问地址”列获取并记录集群的内网IP地址,后续配置模型服务需要使用。

一般是“<host>:<port>”或“<host>:<port>,<host>:<port>”样式。

图1 获取集群访问地址

登录Kibana

登录Kibana进入命令执行页面。Elasticsearch集群支持多种客户端访问,本文仅以 CSS 服务集成的Kibana为例介绍配置指导。

- 登录 云搜索 服务管理控制台。

- 在左侧导航栏,选择“集群管理 > Elasticsearch”。

- 在集群列表,选择目标集群,单击操作列的“Kibana”,登录Kibana。

- 在Kibana左侧导航栏选择“Dev Tools”,进入操作页面。

控制台左侧是命令输入框,其右侧的三角形图标为执行按钮,右侧区域则显示执行结果。

配置模型服务

当模型创建完成后,根据业务需要配置模型服务。下面介绍了各类模型服务的配置指导。

配置Embedding模型服务

在Kibana中执行以下命令,配置Embedding模型服务。其中,模型类型必须是semantic_vector。

PUT _inference/model_service/{service_name} { "description": "搜索大模型-语义向量化", "service_config": { "semantic_vector": { "service_urls" : ["http://{endpoint}/app/search/v1/vector"], "algorithm": "GRAPH", "metric": "inner_product", "dimension": "768", "timeout_ms": 30000 } } }

|

参数 |

是否必选 |

参数类型 |

描述 |

|---|---|---|---|

|

service_name |

是 |

String |

模型服务的名称。自定义,如pangu_vector。 |

|

service_urls |

是 |

List<String> |

访问模型服务的接口URL。 支持配置多个访问地址,用逗号分隔。 配置格式:http://{endpoint}/app/search/v1/vector,endpoint参考获取独享版集群的访问地址获取。 举例:http://192.168.0.85:18088/app/search/v1/vector |

|

method |

否 |

String |

模型服务的访问方法。 由Embedding模型服务决定,搜索大模型使用的是POST,保持默认值即可。 取值范围:POST、GET、PUT 默认值:POST |

|

algorithm |

否 |

String |

模型服务支持的向量索引算法。 取值范围:

默认值:GRAPH |

|

metric |

否 |

String |

计算向量之间距离的度量方式。 取值范围:

默认值:inner_product |

|

dimension |

否 |

String |

向量数据维度。 由Embedding模型服务决定,必须配置为768,保持默认值即可。 取值范围:1~4096 默认值:768 |

|

timeout_ms |

否 |

int |

访问模型服务的超时时间,超时会请求失败。 单位:ms(毫秒) 最小值:3000 默认值:10000 |

|

content_length |

否 |

int |

模型服务支持单个文档属性的最大值,超过最大值将进行文本截断。 默认值:-1(小于0代表不进行长度截断) |

|

embedding_type |

否 |

String |

配置Embedding模型的查询类型。

取值范围:

默认值:query2doc |

配置Rerank模型服务

在Kibana中执行以下命令,配置Rerank模型服务。其中,模型类型必须是reorder。

PUT _inference/model_service/{service_name} { "description": "搜索大模型-精排模型", "service_config": { "reorder": { "service_urls": ["http://{endpoint}/app/search/v1/rerank"], "timeout_ms": 60000 } } }

|

参数 |

是否必选 |

参数类型 |

描述 |

|---|---|---|---|

|

service_name |

是 |

String |

模型服务的名称。自定义,如pangu_ranking。 |

|

service_urls |

是 |

List<String> |

访问模型服务的接口URL。 支持配置多个访问地址,用逗号分隔。 配置格式:http://{endpoint}/app/search/v1/rerank,endpoint参考获取独享版集群的访问地址获取。 举例:http://192.168.0.85:18088/app/search/v1/rerank |

|

method |

否 |

String |

模型服务的访问方法。 由Rerank模型服务决定,搜索大模型使用的是POST,保持默认值即可。 取值范围:POST、GET、PUT 默认值:POST |

|

timeout_ms |

否 |

int |

访问模型服务的超时时间,超时会请求失败。 单位:ms(毫秒) 最小值:3000 默认值:10000 |

|

content_length |

否 |

int |

模型服务支持单个文档属性的最大值,超过最大值将进行文本截断。 默认值:-1(小于0代表不进行长度截断) |

管理模型服务

搜索大模型插件深度集成Kibana命令行界面(CLI),支持对模型服务进行更新、监控、扩缩容等全生命周期管理。如表4所示,可以通过标准CLI命令执行更新(update)、删除(delete)等核心操作管理模型服务。

|

操作类型 |

API命令 |

请求示例 |

响应示例 |

|---|---|---|---|

|

更新模型服务 |

POST _inference/model_service/{service_name}/update |

更新Embedding模型服务: POST _inference/model_service/pangu_vector/update

{

"description": "搜索大模型-语义向量化模型更新",

"service_config": {

"semantic_vector": {

"service_urls": ["http://{endpoint}/app/search/v1/vector"],

"timeout_ms": 60000

}

}

} |

返回更新后的模型服务信息: {

"service_name" : "pangu_vector",

"service_type" : "remote",

"description" : "搜索大模型-语义向量化模型更新",

"create_time" : 1747966388508,

"service_config" : {

"semantic_vector" : {

"embedding_type" : "query2doc",

"service_urls" : [

"http://{endpoint}/app/search/v1/vector"],

"method" : "POST",

"timeout_ms" : 60000,

"max_conn" : 200,

"security" : false,

"dimension" : "768",

"algorithm" : "GRAPH",

"metric" : "inner_product"

}

}

} |

|

检查模型服务连通性 |

GET _inference/model_service/{service_name}/check |

检查Embedding模型服务的连通性: GET _inference/model_service/pangu_vector/check |

{

"acknowledged" : true

} |

|

查看模型服务 |

|

查看Embedding模型服务的配置信息: GET _inference/model_service/pangu_vector |

返回模型服务信息: {

"count" : 1,

"model_service_configs" : [

{

"service_name" : "pangu_vector",

"service_type" : "remote",

"description" : "搜索大模型-语义向量化模型",

"create_time" : 1747966388508,

"service_config" : {

"semantic_vector" : {

"embedding_type" : "query2doc",

"service_urls" : ["http://{endpoint}/app/search/v1/vector"],

"method" : "POST",

"timeout_ms" : 60000,

"max_conn" : 200,

"security" : false,

"dimension" : "768",

"algorithm" : "GRAPH",

"metric" : "inner_product"

}

}

}

]

} |

|

删除模型服务配置(删除后,索引将无法使用该模型服务) |

DELETE _inference/model_service/{service_name} |

删除Embedding模型服务配置: DELETE _inference/model_service/pangu_vector |

{

"acknowledged" : true

} |

|

设置模型服务的数量上限(最多支持创建几个模型服务) |

PUT _cluster/settings

{

"transient": {

"pg_search.inference.max_inference_model_service": 100 //最大值是1000,最小值是1,默认值是100。

}

} |

设置模型服务的数量上限为10: PUT _cluster/settings

{

"transient": {

"pg_search.inference.max_inference_model_service": 10

}

} |

{

"acknowledged" : true,

"persistent" : { },

"transient" : {

"pg_search" : {

"inference" : {

"max_inference_model_service" : "10"

}

}

}

} |

ai智能文本校对大模型将到来常见问题

更多常见问题 >>-

盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合,重塑千行百业,成为各组织、企业、个人的专家助手。

-

模型转换,即将开源框架的网络模型(如Caffe、TensorFlow等),通过ATC(Ascend Tensor Compiler)模型转换工具,将其转换成昇腾AI处理器支持的离线模型。

-

本次Serverless应用中心上线文生图应用,用户无需下载源代码、了解各种安装部署知识、安装复杂的依赖,通过华为云Serverless应用中心即可一键创建AI文生图应用,体验 “0” 构建门槛、“0” 资源闲置并具备极致弹性的Serverless AI绘图能力。

-

华为云CodeArts Snap是一款基于大模型技术打造的智能开发助手,旨在提高开发人员的生产力和代码质量,为开发者带来全新的编程方式和体验。

-

在自然语言处理(NLP)领域中,使用语言模型预训练方法在多项NLP任务上都获得了不错的提升,广泛受到了各界的关注。本课程将简单介绍一下预训练的思想,几个代表性模型和它们之间的关系。

-

华为云Serverless技术极大的优化了AI应用开发过程,一键部署AI应用、提升开发团队工作效率。让AI团队可以更关注业务实现,而无需关注底层技术细节。

更多相关专题

增值电信业务经营许可证:B1.B2-20200593 | 域名注册服务机构许可:黔D3-20230001 | 代理域名注册服务机构:新网、西数