识别并拦截恶意提示词,防止大模型被诱导生成不当内容。 内容合规审核 对大模型输出内容进行实时审核,确保符合相关法律法规和企业政策。 数据隐私保护 监测并防止敏感数据泄露,保障用户隐私安全。 大模型防火墙应用场景 面向大模型推理应用场景提供全栈纵深的安全防御能力,保护AI应用稳定可靠运行 大模型防火墙

全链路专业服务,让大模型从可用到好用 · 6大阶段30+专业服务,覆盖大模型建设全流程,加速政企落地大模型 · 创新运营服务模式,实现全场景模型经验沉淀、全流程运营赋能产业,快速孵化大模型场景化应用 大模型混合云十大创新技术 大模型混合云十大创新技术 了解详情 十大创新技术 加速构建企业专属大模型

盘古大模型 PanguLargeModels 盘古大模型 PanguLargeModels 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构

使用预置算法构建模型 使用自定义算法构建模型 查看全部 即刻领取 免费试用 产品 开启您的大模型之旅 企业免费试用 您可能感兴趣的产品 您可能感兴趣的产品 大模型开发平台ModelArts Studio 一站式大模型工具链平台 ModelArts 面向开发者的AI平台

盘古NLP大模型 盘古NLP大模型 优秀的模型结构,完善的工程化能力,最贴合行业落地的NLP大模型 超大参数规模,最贴合行业落地的NLP大模型 重磅发布盘古NLP 718B深度思考模型,多专家+大稀疏比的MOE新架构,昇腾亲和设计,高效训推 专家咨询 ModelArts Studio控制台

化区域的基础大模型。 全球模型 提供高精度的全球模型,无需定制和训练,直接订阅即可推理 多种部署形态 支持公有云、混合云、边缘多种形态,满足不同需求 文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古科学计算大模型能力与规格 盘古大模型用户指南 如何调用盘古大模型API

古多模态大模型为基座,持续优化万兴天幕音视频大模型2.0,构建其音视频垂类能力。 广汽集团 广汽借助华为云盘古多模态大模型,打造业界首个支持点云生成的大模型,为其端到端仿真高效迭代提供强有力支撑。 文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古多模态大模型能力与规格

大模型混合云TOP N 场景 大模型混合云TOP N 场景 1对1咨询 了解华为云Stack 大模型行业场景落地三要素 大模型行业场景落地三要素 场景是大模型行业落地的关键所在,而在场景落地过程中,数据、经验和生态是核心要素,数据的数量和质量决定模型效果上限;经验就像“名师指导”

多语种内容审核,平台全面保护 一站式大模型开发平台 一站式大模型开发平台 ModelArts Studio大模型开发平台是集数据管理、模型训练、模型部署于一体的综合平台,专为开发和应用大模型而设计,旨在为开发者提供简单、高效的大模型开发和部署方式 为什么选择大模型开发平台ModelArts

《互联网信息服务算法推荐管理规定》明确,具有舆论属性或者社会动员能力的算法推荐服务提供者应当在提供服务之日起十个工作日内通过互联网信息服务算法备案系统填报服务提供者的名称、服务形式、应用领域、算法类型、算法自评估报告、拟公示内容等信息 方便

湘江鲲鹏目前在人工智能大模型领域拥有算力、数据、算法三大关键要素的经验积累,构建了大模型三个方面的差异化竞争力,盘古大模型AI专业服务覆盖从前期咨询、规划设计,到数据工程、模型训练,再到应用工程及模型运维的完整流程。基于华为盘古提供的AI专业服务包,致力于为企业提供一站式人工智能解决方案

等,以及整体的规划设计(需求、思路、方案、架构、落地周期、预算等)。3. 数据的咨询、治理和梳理,数据的采集(各业务系统中的多种业务模型、网络等等),数据的标注,关联关系的定义,以及数据导入。4. 基于具体任务和对应的数据分布,设计适合的微调训练框架和方案;使用不同的调参策略和技

,满足企业在不同地点的工作需求。5、我们保证了业务的高质量数据供给。我们的工作站拥有强大的数据处理能力,可以提供高质量的数据,帮助企业做出更好的决策。总的来说,太杉天尊大模型AIGC场景解决方案具备功能强大、安全可靠、易于使用的特点,是政府的得力助手,企业的重要伙伴。1、数据私有化;

%+,能够为客户提供定制化的解决方案。 公司集成了世界领先的底层大模型,具备打通跨模型和工具链的平台能力,采用最新的人工智能技术和算法,能够基于业务场景,支持大规模数据处理和复杂的模型训练,根据客户的特定需求调整模型参数和功能,确保为客户提供高效、可靠的技术服务,以满足业务目标。

择和技术方案设计。提供NLP/CV等大模型的训练集数据标准设计指导。2. 规划设计:提供需求调研服务,基于盘古大模型的能力进行科学合理的方案设计和模型选择。完成需求调研报告和方案设计报告的输出及交付。提供L0盘古大模型服务部署方案的规划设计及部署实施服务。3. 数据工程:

注&撰写根据大模型微调数据标注规范,通过配套工具进行数据标注。 八、数据转换与导入 完成数据格式的转换,可进行跨网络环境的数据导入。 九、调优方案设计 根据大模型训练及调优工具和平台,输出大模型调优方案。 十、模型训练实施1. 基于大模型训练所需的云服务,完成大模型训练及微调。2

、安全的工作环境。1、我们特别注重数据私有化。我们采用最新的数据加密技术,确保企业的数据安全。每一个工作站都拥有独立的存储空间,企业的数据不会被未经授权的第三方访问。2、我们提供了场景定制的服务。我们的工作站可以根据企业的具体需求,进行个性化设计,以满足企业在不同场景下的工作需求

出门问问大模型“序列猴子”是一款具备多模态生成能力的大语言模型,模型以语言为核心的能力体系涵盖“知识、对话、数学、逻辑、推理、规划”六个维度,能够同时支持文字生成、图片生成、3D内容生成、语言生成和语音识别等不同任务。出门问问大模型“序列猴子”是一款具备多模态生成能力的大语言模型,模

深厚的行业积累,分层解耦的架构,多样化的部署模式 深厚的行业积累,分层解耦的架构,多样化的部署模式 技术扎根 全栈技术创新,极致算力加速大模型开发,打造世界AI另一极 全栈技术创新,极致算力加速大模型开发,打造世界AI另一极 开放同飞 打造云原生应用平台AppArts,成立大模型高质量数据联盟

免费AI客服电话的服务: 铁三角服务体系,每名客户提供不少于3人的运维辅助客户成功 免费AI客服电话的产品: 3年积累,国家高新技术企业,专注SAAS服务 免费AI客服电话的技术: NLP自然语义理解,高对话能力 免费AI客服电话的矩阵: 提供从线路、线索、机器人、企业微信SCRM一体化服务,可以OEM

ModelArts提供了模型训练的功能,方便您查看训练情况并不断调整您的模型参数。您还可以基于不同的数据,选择不同规格的资源池用于模型训练。除支持用户自己开发的模型外,ModelArts还提供了从AI Gallery订阅算法,您可以不关注模型开发,直接使用AI Gallery的算法,通过算法参数的调整,得到一个满意的模型。

有活动时,可能有可以免费试用的活动。您可以关注华为云的企业邮箱活动。 企业邮箱怎么收费 华为云企业邮箱中,云速邮箱的收费主要看您购买的时长和购买的账号数量,购买的实时价格可参考本内容。 华为云企业邮箱一年多少钱 您购买的账号数不同的话,价格也会有所不同。当前购买华为云企业邮箱,1年8折。

将代码目录中除代码以外的文件删除或存放到其他目录,保证代码目录大小不超过128MB,文件个数不超过4096个。 训练作业的“/cache”目录是否安全? ModelArts训练作业的程序运行在容器中,容器挂载的目录地址是唯一的,只有运行时的容器能访问到。因此训练作业的“/cache”是安全的。

云资源的,IAM权限定义了允许和拒绝的访问操作,以此实现云资源权限访问控制。 了解详情 云专线DC-专线接入点 您可以自主选择运营商的专线,连接华为云专线接入点,并自助购买对应的端口资源,完成物理连接接入。 您可以自主选择运营商的专线,连接华为云专线接入点,并自助购买对应的端口资源,完成物理连接接入。

平台设置设备属性 设备的产品模型中定义了平台可向设备设置的属性,平台/应用服务器可通过属性设置的方式修改指定设备的属性值。 平台查询设备属性 平台/应用服务器通过属性查询的方式,实时查询指定设备的属性数据。 平台命令下发 平台/应用服务器按产品模型中定义的命令格式下发控制命令给设备。

检查应用服务器是否集成了物联网平台的证书,证书由物联网平台服务商提供。 根据API参考的鉴权接口,检查URL、body、header的参数信息是否正确。 使用MQTT协议的设备如何接入? MQTT协议的设备可以根据开发语言、设备的操作系统及资源情况选择不同协议的SDK接入,或者使用原生MQTT协议接入。详细请参考设备侧接入。

户应用或者云服务。 不支持MQTT协议规范中retain msg。IoTDA提供消息缓存的能力消息上报和消息下发时支持对消息进行缓存。 支持的MQTT 5.0特性说明 华为云设备接入服务IoTDA服务支持的MQTT 5.0的部分新增特性如下: 支持Topic Alias。将消息通

免费的ai大模型接入

在 ModelArts Studio大模型即服务平台部署成功的模型服务支持在其他业务环境中调用。本文以我的服务为例,调用部署的模型服务。您也可以调用预置服务-免费服务、预置服务-商用服务或自定义接入点。

操作场景

在企业AI应用开发过程中,开发人员通常需要将训练好的模型部署到实际业务环境中。然而,传统方法需要手动配置环境、处理依赖关系、编写部署脚本,整个过程耗时且容易出错,且存在环境复杂、迁移困难、维护成本高、版本更新麻烦等问题。

ModelArts Studio(MaaS)大模型即服务平台提供了一站式解决方案,提供统一的API接口方便业务系统调用,并提供监控和日志功能便于运维管理。

计费说明

在调用模型推理服务的过程中,输入内容首先会被分词(tokenize),转换为模型可识别的Token。在调用MaaS预置服务时,将根据实际使用的Tokens数量进行计费。计费详情请参见计费说明。

约束限制

对于支持图片上传的模型,单个图片文件的大小不超过10MB。如果以Base64编码形式上传图片,需确保编码后的图片小于10MB。

前提条件

- 使用预置服务:在“在线推理”页面的“预置服务”页签,使用有效期内的免费服务或者已开通商用服务(付费状态为“开通”)。具体操作,请参见ModelArts Studio(MaaS)在线推理服务。

- 使用我的服务:在“在线推理”页面的“我的服务”页签,服务列表存在运行中、更新中或升级中的模型服务。具体操作,请参见使用ModelArts Studio(MaaS)部署模型服务。

- 使用自定义接入点:已创建自定义接入点。具体操作,请参见在ModelArts Studio(MaaS)创建自定义接入点。

步骤一:获取API Key

在调用MaaS部署的模型服务时,需要填写API Key用于接口的鉴权认证。最多可创建30个密钥。每个密钥仅在创建时显示一次,请确保妥善保存。如果密钥丢失,无法找回,需要重新创建API Key以获取新的访问密钥。更多信息,请参见在ModelArts Studio(MaaS)管理API Key。

- 登录ModelArts Studio(MaaS)控制台,在顶部导航栏选择目标区域。

- 在左侧导航栏,单击“API Key管理”。

- 在“API Key管理”页面,单击“创建API Key”,填写标签和描述信息后,单击“确定”。

标签和描述信息在创建完成后,不支持修改。

表1 创建API Key参数说明 参数

说明

标签

自定义API Key的标签。标签具有唯一性,不可重复。仅支持大小写英文字母、数字、下划线、中划线,长度范围为1~100个字符。

描述

自定义API Key的描述,长度范围为1~100个字符。

- 在“您的密钥”对话框,复制密钥并保存至安全位置。

- 保存完毕后,单击“关闭”。

单击“关闭”后将无法再次查看密钥。

步骤二:调用MaaS模型服务进行预测

- 在ModelArts Studio(MaaS)控制台左侧导航栏,选择“在线推理”。

- 在“在线推理”页面,单击“我的服务”页签,在目标服务右侧,单击操作列的“更多 > 调用说明”。

- 在“关闭 内容审核 服务”对话框,选择是否启用内容审核(默认启用)。

- 在“调用说明”页面,选择接口类型,复制调用示例,修改接口信息和API Key后用于业务环境调用模型服务API。

Rest API、OpenAI SDK的示例代码如下。

- Rest API示例代码如下所示:

- 使用Python调用示例。

import requests import json if __name__ == '__main__': url = "https:/example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06*****/v1/chat/completions" api_key = "<your_apiKey>" # 把<your_apiKey>替换成已获取的API Key。 # Send request. headers = { 'Content-Type': 'application/json', 'Authorization': f'Bearer {api_key}' } data = { "model": "******", # 调用时的模型名称。 "max_tokens": 1024, # 最大输出token数。 "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "hello"} ], # 是否开启流式推理,默认为False,表示不开启流式推理。 "stream": False, # 在流式输出时是否展示使用的token数目。只有当stream为True时该参数才会生效。 # "stream_options": {"include_usage": True}, # 控制采样随机性的浮点数,值较低时模型更具确定性,值较高时模型更具创造性。"0"表示贪婪取样。默认为0.6。 "temperature": 0.6 } response = requests.post(url, headers=headers, data=json.dumps(data), verify=False) # Print result. print(response.status_code) print(response.text) - 使用cURL调用示例。

curl -X POST "https://example.com/v1/chat/completions" \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $API_KEY" \ -d '{ "model": "DeepSeek-R1", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "你好"} ], "stream": true, "stream_options": { "include_usage": true }, "temperature": 0.6 }'

- 使用Python调用示例。

- 使用OpenAI SDK调用示例。

# 安装环境命令。 pip install --upgrade "openai>=1.0"

# OpenAI SDK调用示例。 from openai import OpenAI if __name__ == '__main__': base_url = "https://example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06******/v1" api_key = "<your_apiKey>" # 把<your_apiKey>替换成已获取的API Key。 client = OpenAI(api_key=api_key, base_url=base_url) response = client.chat.completions.create( model="******", messages=[ {"role": "system", "content": "You are a helpful assistant"}, {"role": "user", "content": "Hello"}, ], max_tokens=1024, temperature=0.6, stream=False ) # Print result. print(response.choices[0].message.content)

模型服务的API与vLLM相同,表2仅介绍关键参数,详细参数解释请参见vLLM官网。使用昇腾云909 镜像 的模型,开启流式输出时,需要新增stream_options参数,值为{"include_usage":true},才会打印token数。

表2 请求参数说明 参数

是否必选

默认值

参数类型

描述

url

是

无

Str

调用时的API地址。假设URL为https://example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06*****/{endpoint} , 其中{endpoint}仅支持如下接口,详细介绍请参见接口调用说明。

- /v1/chat/completions

- /v1/models

model

是

无

Str

调用时的模型名称。

在ModelArts Studio大模型即服务平台的“在线推理”页面,选择调用的模型服务,单击操作列的“更多 > 调用”,在调用页面可以获取“模型名称”。

messages

是

-

Array

请求输入的问题。

messages.role

是

无

Str

不同的role对应不同的消息类型。

- system:开发人员输入的指令,例如模型应遵循的答复格式、扮演的角色等。

- user:用户输入的消息,包括提示词和上下文信息。

- assistant:模型生成的回复内容。

- tool:模型调用工具返回的信息。

messages.content

是

无

Str

- 当role为system时:给AI模型设定的人设。

{"role": "system","content": "你是一个乐于助人的AI助手"} - 当role为user时:用户输入的问题。

{"role": "user","content": "9.11和9.8哪个大?"} - 当role为assistant时:AI模型输出的答复内容。

{"role": "assistant","content": "9.11大于9.8"} - 当role为tool时:AI模型调用的工具响应信息。

{"role": "tool", "content": "上海今天天气晴,气温10度"}

stream_options

否

无

Object

该参数用于配置在流式输出时是否展示使用的token数目。只有当stream为True的时候该参数才会激活生效。如果您需要统计流式输出模式下的token数目,可将该参数配置为stream_options={"include_usage":True}。

max_tokens

否

16

Int

当前任务允许的生成Token数上限,包括模型输出的Tokens和深度思考的Reasoning Tokens。

top_k

否

-1

Int

在生成过程中,候选集大小限定了采样的范围。以取值50为例,这意味着每一步仅会考虑得分排在前50位的Token构成候选集进行随机抽样。增大此值将提高输出的随机性,减小此值会增强输出的确定性。

top_p

否

1.0

Float

模型核采样(nucleus sampling)。仅保留累计概率刚好超过阈值p的那一部分词,其余全部屏蔽,最后在这份候选词里重新归一化并采样。

设置值越小,候选词越少,模型输出越集中和保守;设置值越大,候选词越多,模型输出越开放和多样。

通常情况只建议调整temperature或top_p,不要同时修改两个参数。

取值范围:0~1,设置为“1”表示考虑所有Tokens。

temperature

否

0.6

Float

模型采样温度。设置的值越高,模型输出越随机;设置的值越低,输出越确定。

通常情况只建议调整temperature或top_p,不要同时修改两个参数。

temperature取值建议:DeepSeek-R1、DeepSeek-V3、Qwen3系列建议值为0.6,Qwen2.5-VL系列建议值为0.2。

stop

否

None

None/Str/List

用于停止生成的字符串列表。返回的输出将不包含停止字符串。

例如,设置为["你","好"]时,在生成文本过程中,遇到“你”或者“好”将停止文本生成。

stream

否

False

Bool

是否开启流式推理。默认为False,表示不开启流式推理。

n

否

1

Int

为每个输入的消息生成的响应数。

- 不使用beam_search场景下,n取值建议为1≤n≤10。如果n>1时,必须确保不使用greedy_sample采样,也就是top_k > 1,temperature > 0。

- 使用beam_search场景下,n取值建议为1<n≤10。如果n=1,会导致推理请求失败。

说明:n建议取值不超过10,n值过大会导致性能劣化,显存不足时,推理请求会失败。

use_beam_search

否

False

Bool

是否使用beam_search替换采样。

使用该参数时,如下参数必须按要求设置。

- n:大于1

- top_p:1.0

- top_k:-1

- temperature:0.0

presence_penalty

否

0.0

Float

presence_penalty表示会根据当前生成的文本中新出现的词语进行奖惩。取值范围[-2.0,2.0]。

frequency_penalty

否

0.0

Float

frequency_penalty会根据当前生成的文本中各个词语的出现频率进行奖惩。取值范围[-2.0,2.0]。

length_penalty

否

1.0

Float

length_penalty表示在beam search过程中,对于较长的序列,模型会给予较大的惩罚。

使用该参数时,必须添加如下三个参数,且必须按要求设置。

- top_k:-1

- use_beam_search:true

- best_of:大于1

- 普通requests包、OpenAI SDK、curl命令的返回示例如下所示:

{ "id": "cmpl-29f7a172056541449eb1f9d31c*****", "object": "chat.completion", "created": 17231*****, "model": "******", "choices": [ { "index": 0, "message": { "role": "assistant", "content": "你好!很高兴能为你提供帮助。有什么问题我可以回答或帮你解决吗?" }, "logprobs": null, "finish_reason": "stop", "stop_reason": null } ], "usage": { "prompt_tokens": 20, "total_tokens": 38, "completion_tokens": 18 } } - 思维链模型的返回示例如下所示:

messages = [{"role": "user", "content": "9.11 and 9.8, which is greater?"}] response = client.chat.completions.create(model=model, messages=messages) reasoning_content = response.choices[0].message.reasoning_content content = response.choices[0].message.content print("reasoning_content:", reasoning_content) print("content:", content)

表3 返回参数说明 参数

参数类型

描述

id

Str

请求ID。

object

Str

请求任务。

created

Int

请求生成的时间戳。

model

Str

调用的模型名。

choices

Array

模型生成内容。

usage

Object

请求输入长度、输出长度和总长度。

- prompt_tokens:输入Tokens数。

- completion_tokens:输出Tokens数。

- total_tokens:总Tokens数。

总Tokens数 = 输入Tokens数 + 输出Tokens数

reasoning_content

Str

当模型支持思维链时,模型的思考内容。对于支持思维链的模型,开启流式输出时,会首先在reasoning_content字段输出思考内容,然后在content中输出回答内容。

content

Str

模型的回答内容。

当调用失败时,可以根据错误码调整脚本或运行环境。表4 常见错误码 错误码

错误内容

说明

400

Bad Request

请求包含语法错误。

403

Forbidden

服务器拒绝执行。

404

Not Found

服务器找不到请求的网页。

500

Internal Server Error

服务内部错误。

- Rest API示例代码如下所示:

内容审核说明

- 流式请求

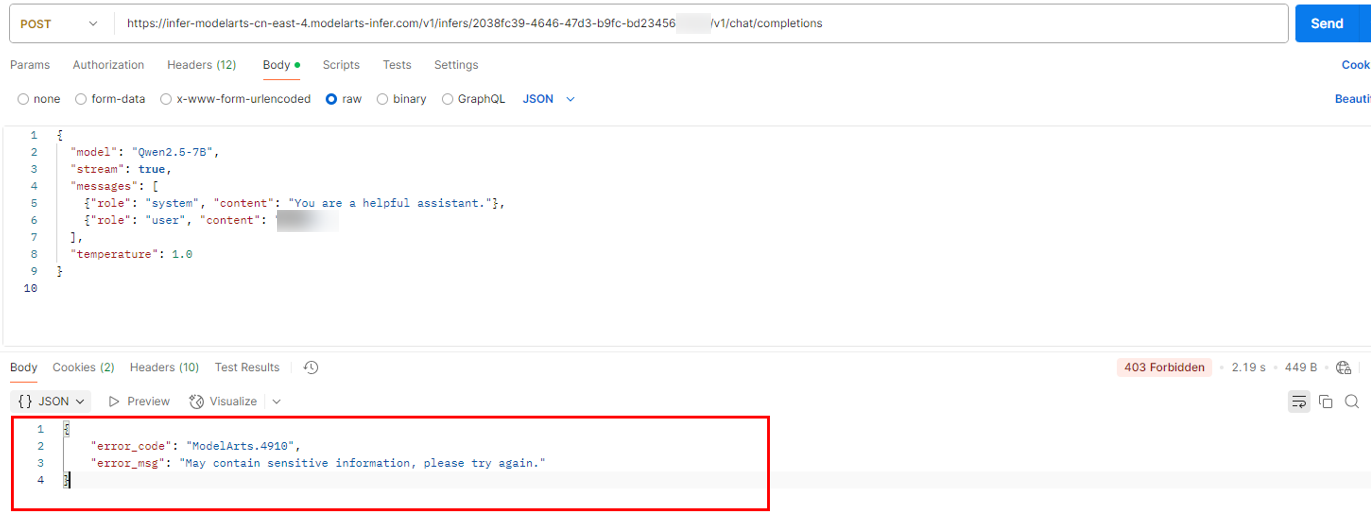

- 如果触发内容审核,则会返回错误:错误码403。您可以通过错误码ModelArts.81011来判断。返回内容如下:

{ "error_code": "ModelArts.81011", "error_msg": "May contain sensitive information, please try again." }图1 报错示例

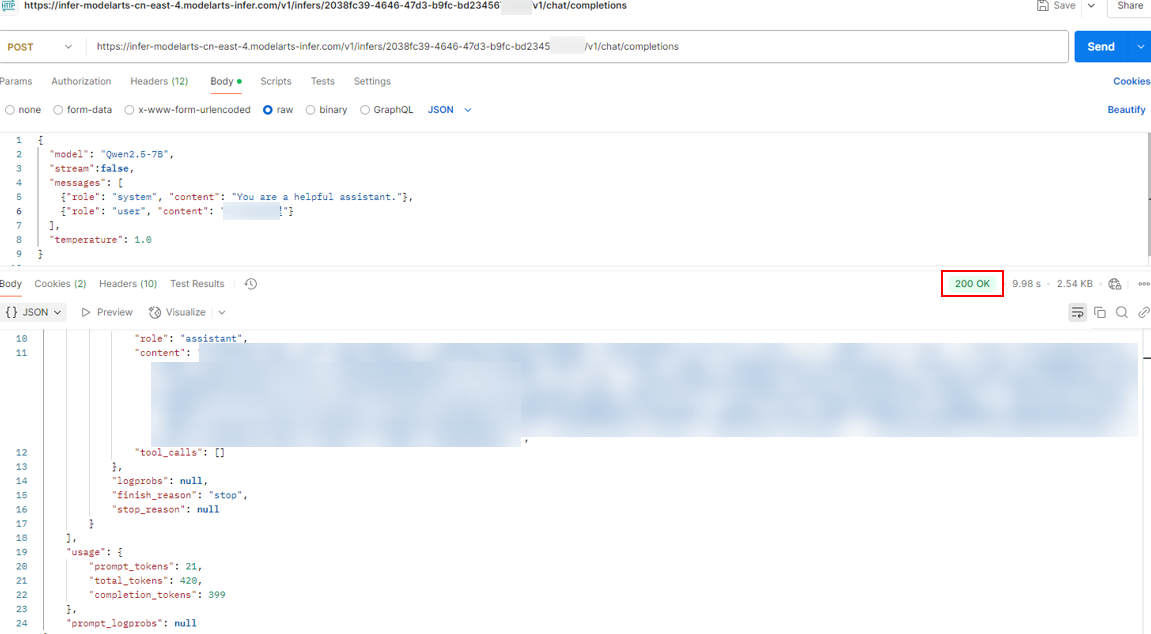

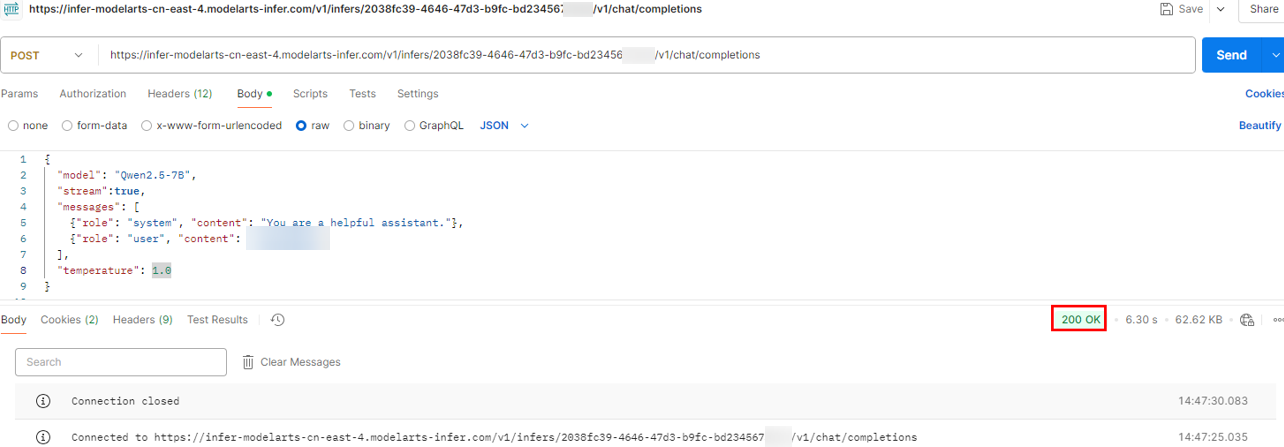

- 如果未触发内容审核,则使用postman调用返回参考如下,返回码200。

图2 正常返回示例

- 如果输出有敏感信息,则会在输出流后面拼接如下数据:

data: {"id":"chatcmpl-*********************","object":"chat.completion","created":1678067605,"model":"******","choices":[{"delta":{"content":"这是流式响应的开始。"},"index":0}] data: {"id":"chatcmpl-*********************","object":"chat.completion","created":1678067605,"model":"******","choices":[{"delta":{"content":" 继续输出结果。"},"index":0}] data: {"id":"chatcmpl-*********************","object":"chat.completion","created":1678067605,"model":"******","choices":[{"finish_reason":"content_filter","index":0}]} data: [DONE]触发内容审核之后,"finish_reason"是"content_filter";正常的流式停止是 "finish_reason":"stop"。

- 如果触发内容审核,则会返回错误:错误码403。您可以通过错误码ModelArts.81011来判断。返回内容如下:

- 非流式请求

接口调用说明

假设API地址为https://example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06*****/{endpoint} ,其中{endpoint}仅支持如下接口:

- /v1/chat/completions

- /v1/models

注意:

- /v1/models使用GET方法不需要请求体,而/v1/chat/completions需要POST请求方式和对应的JSON请求体。

- 通用请求头为Authorization: Bearer YOUR_API_KEY,对于POST请求,还需包含Content-Type: application/json。

|

类型/接口 |

/v1/models |

/v1/chat/completions |

|---|---|---|

|

请求方法 |

GET |

POST |

|

用途 |

获取当前支持的模型列表。 |

用于聊天对话型生成调用。 |

|

请求体说明 |

无需请求体,仅需通过请求头传入认证信息。 |

|

|

请求示例 |

GET https://example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06*****/v1/models HTTP/1.1 Authorization: Bearer YOUR_API_KEY |

POST https://example.com/v1/infers/937cabe5-d673-47f1-9e7c-2b4de06*****/v1/chat/completions HTTP/1.1

Content-Type: application/json

Authorization: Bearer YOUR_API_KEY

{

"model": "******",

"messages": [

{"role": "user", "content": "Hello, how are you?"}

],

"temperature": 0.7

} |

|

响应示例 |

{

"data": [

{

"id": "******",

"description": "最新一代大模型"

},

{

"id": "******",

"description": "性价比较高的替代方案"

}

]

} |

{

"id": "******",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {"role": "assistant", "content": "I'm doing well, thank you! How can I help you today?"}

}

],

"usage": {

"prompt_tokens": 15,

"completion_tokens": 25,

"total_tokens": 40

}

} |

常见问题

在ModelArts Studio(MaaS) 创建API Key后需要等待多久才能生效?

MaaS API Key在创建后不会立即生效,通常需要等待几分钟才能生效。

免费的ai大模型接入常见问题

更多常见问题 >>-

盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合,重塑千行百业,成为各组织、企业、个人的专家助手。

-

模型转换,即将开源框架的网络模型(如Caffe、TensorFlow等),通过ATC(Ascend Tensor Compiler)模型转换工具,将其转换成昇腾AI处理器支持的离线模型。

-

本次Serverless应用中心上线文生图应用,用户无需下载源代码、了解各种安装部署知识、安装复杂的依赖,通过华为云Serverless应用中心即可一键创建AI文生图应用,体验 “0” 构建门槛、“0” 资源闲置并具备极致弹性的Serverless AI绘图能力。

-

华为云Serverless技术极大的优化了AI应用开发过程,一键部署AI应用、提升开发团队工作效率。让AI团队可以更关注业务实现,而无需关注底层技术细节。

-

在自然语言处理(NLP)领域中,使用语言模型预训练方法在多项NLP任务上都获得了不错的提升,广泛受到了各界的关注。本课程将简单介绍一下预训练的思想,几个代表性模型和它们之间的关系。

-

华为云CodeArts Snap是一款基于大模型技术打造的智能开发助手,旨在提高开发人员的生产力和代码质量,为开发者带来全新的编程方式和体验。

更多相关专题

增值电信业务经营许可证:B1.B2-20200593 | 域名注册服务机构许可:黔D3-20230001 | 代理域名注册服务机构:新网、西数