赋能千行万业 全链路专业服务,让大模型从可用到好用 · 6大阶段30+专业服务,覆盖大模型建设全流程,加速政企落地大模型 · 创新运营服务模式,实现全场景模型经验沉淀、全流程运营赋能产业,快速孵化大模型场景化应用 大模型混合云十大创新技术 大模型混合云十大创新技术 了解详情 十大创新技术

优质昇腾云AI模型专区 几行代码自由部署AI应用 丰富多样的AI训练数据集 场景化AI案例,助力AI赋能千行百业 查看全部 学习资源 学习资源 AI开发基本流程介绍 自动学习简介 使用预置算法构建模型 使用自定义算法构建模型 查看全部 即刻领取 免费试用 产品 开启您的大模型之旅 企业免费试用

盘古大模型 PanguLargeModels 盘古大模型 PanguLargeModels 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构 盘古大模型是面向B端行业的大模型,包含L0中5类基础大模型、L1行业大模型及L2场景模型三层架构

文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古预测大模型能力与规格 盘古大模型快速入门 如何调用盘古大模型API 查看全部 AI Gallery百模千态社区 AI Gallery百模千态社区 优质昇腾云AI模型专区 几行代码自由部署AI应用 丰富多样的AI训练数据集 场景化AI案例,助力AI赋能千行百业

广汽借助华为云盘古多模态大模型,打造业界首个支持点云生成的大模型,为其端到端仿真高效迭代提供强有力支撑。 文档与学习成长 盘古大模型 盘古大模型 什么是盘古大模型 盘古多模态大模型能力与规格 用户指南 如何调用盘古大模型API 查看全部 AI Gallery百模千态社区 AI Gallery百模千态社区

AI开发平台ModelArts入门 AI平台ModelArts入门 面向开发者的一站式AI开发平台,可快速创建和部署模型,管理全周期AI工作流,助力千行百业智能升级 面向开发者的一站式AI开发平台,可快速创建和部署模型,管理全周期AI工作流,助力千行百业智能升级 购买 控制台 专家咨询

盘古大模型 盘古大模型 盘古行业大模型 盘古行业大模型 盘古行业大模型化解行业数据构建难、模型效果调优难、场景能力评测难三大难题,助力行业客户更快、更优构建专业大模型 盘古行业大模型化解行业数据构建难、模型效果调优难、场景能力评测难三大难题,助力行业客户更快、更优构建专业大模型 专家咨询

AI科学计算服务 AI科学计算服务 AI科学计算服务(AI for Science Service),是一个致力于将人工智能技术与科学研究相结合的创新平台。 面向生物医药、计算化学、地球科学、电磁学、流体等科学领域,提供开箱即用的澎湃算力及调度能力, 内置丰富的各领域AI模型、分

AI平台ModelArts资源 AI平台ModelArts资源 面向开发者的一站式AI开发平台,可快速创建和部署模型,管理全周期AI工作流,助力千行百业智能升级 面向开发者的一站式AI开发平台,可快速创建和部署模型,管理全周期AI工作流,助力千行百业智能升级 购买 控制台 文档 资源与工具

智慧监控AI模型综合集成了人脸识别模型、安全帽识别模型、口罩佩戴识别模型、车牌识别模型、车辆占道识别模型5种AI模型。一,人脸识别服务 人脸识别模型目前提供授权认证、模型加载、人脸注册、人脸识别、人脸删除、特征提取六个接口服务。 授权认证:需先进行授权认证,才能够正常使用人脸识别服务;

《互联网信息服务算法推荐管理规定》明确,具有舆论属性或者社会动员能力的算法推荐服务提供者应当在提供服务之日起十个工作日内通过互联网信息服务算法备案系统填报服务提供者的名称、服务形式、应用领域、算法类型、算法自评估报告、拟公示内容等信息 方便

云坞网络专注于利用先进的AI云计算、大数据和人工智能技术,为企业提供卓越的ChatGPT行业解决方案。帮助企业快速实现数字化、智能化和绿色化转型。 系统定制开发:我们可以为客户提供系统的定制开发服务,帮助客户实现更多的个性化功能和业务流程需求。,数据迁移:我们帮助客户将现有系统的

湘江鲲鹏目前在人工智能大模型领域拥有算力、数据、算法三大关键要素的经验积累,构建了大模型三个方面的差异化竞争力,盘古大模型AI专业服务覆盖从前期咨询、规划设计,到数据工程、模型训练,再到应用工程及模型运维的完整流程。基于华为盘古提供的AI专业服务包,致力于为企业提供一站式人工智能解决方案

angChain等流行的大模型开发框架,构建企业级AI应用;团队拥有成熟的软件工程技术和管理能力。6. 大模型使用的技术支持,用户使用大模型平台,解答用户使用过程遇到的问题;大模型与应用对接集成,以及进行日常巡检、故障处理、模型升级等服务。4. 工业数据模型(CAD模型、CAE模

太杉天尊大模型AIGC场景解决方案是以AI场景解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。具备自研的行业模型能力,主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。太杉天尊大模型AIGC场景解决方案,是一款专为满足政府企

公司集成了世界领先的底层大模型,具备打通跨模型和工具链的平台,提供从需求分析、数据收集、模型设计、训练优化、评估、系统集成、用户界面设计、部署维护、合规性检查、技术支持、性能监控、扩展性设计、定制服务到持续研发一站式AI大模型定制研发服务。光启慧语是一家围绕大模型全栈开展技术研发和产品

数据质量。4. 模型训练:设计调优方案,实施模型训练,并进行模型评测。熟悉盘古大模型工作流和云服务操作,确保模型效果优化。5. 应用工程:提供基于大模型能力的Agent开发和应用对接服务。具备良好的软件开发和沟通能力,实现大模型与应用的无缝对接。6. 模型运维: 提供技

天尊大模型AIGC场景解决方案配套服务是太杉AIGC解决方案的人工服务,是以AI应用解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。天尊大模型AIGC场景解决方案配套服务是太

了解详情 盘古预测大模型 盘古预测大模型是面向结构化类数据,基于10类2000个基模型空间,通过模型推荐、融合两步优化策略,构建图网络架构AI模型。 了解详情 盘古科学计算大模型 科学计算大模型是面向气象、医药、水务、机械、航天航空等领域,采用AI数据建模和AI方程求解的方法;从海

入镜像创建AI为应用。 帮助文档 收起 展开 本地准备模型包 收起 展开 在本地准备模型包,编写模型配置文件和模型推理代码,将准备好的模型包上传至对象存储服务OBS,从OBS导入模型创建为AI应用。 帮助文档 收起 展开 AI Gellary订阅模型 收起 展开 在AI Gall

ModelArts模型训练 ModelArts模型训练简介 ModelArts模型训练,俗称“建模”,指通过分析手段、方法和技巧对准备好的数据进行探索分析,从中发现因果关系、内部联系和业务规律,为商业目的提供决策参考。训练模型的结果通常是一个或多个机器学习或深度学习模型,模型可以应用到新的数据中,得到预测、评价等结果。

免费AI客服电话-云蝠智能AI客户联络中心 免费AI客服电话-云蝠智能AI客户联络中心 “云蝠智能”企业提供AI客户联络中心,包含智能语音电话机器人、智能语音呼叫、短信分发及企业微信SCRM的业务体系。通过提供AI会员回访、通知、精准营销的系统进行产品服务和赋能。 “云蝠智能”企

iS-RPM)是艺赛旗凭借十余年的行为智能分析经验,经过深入研究与开发出的端到端业务流程发现智能平台。 访问店铺 嗨普营销自动化管理软件 HyBot是一款基于gpt-3.5-turbo模型的虚拟助手,使用了目前最先进的Chat AI大言语数据模型技术,强大的HyBot可以为您提供各

快速购买为您提高了配置效率,可以在几分钟之内快速购买基于公有云平台的弹性云服务器设施,更加方便快捷。 类型 实例规格 云硬盘 显卡 标准库支持 适用场景 Ai1s(昇腾310) vCPU 2/4/8/16/32核 内存 8/16/32/64/128GB 40GB(默认) 1/2/4/8/16 Ascend

从而实现数据全生命周期内的安全保护。 AI-Native自治,管理智能高效 AI-Native自治,管理智能高效 参数自调优 当前已经覆盖了500+重点参数,通过深度强化学习与全局调优算法,结合不同业务负载模型进行针对性调优,相比DBA人工根据经验调优,性能提升30%的同时,耗费时间从天下降到分钟级。

图文档资料审批流程,通过标准化的图文档模板库和规范化的文档编号,确保图文档的标准化和规范化产生,并实现高效的流转。3. 智能的版本管理及借用管理:软件具备智能的版本管理功能,可以降低企业图纸版本出错率,提高数据重用率,减少重复工作。4. 严密的权限管理:软件提供严密的权限管理功能

MES系统排名 MES系统排名 这是一款极轻、极易、极智能的MES系统,它为满足中小型数字化工厂建设、智慧车间改造、车间产线智能化改造配套管理系统需求而打造。 这是一款极轻、极易、极智能的MES系统,它为满足中小型数字化工厂建设、智慧车间改造、车间产线智能化改造配套管理系统需求而打造。

ai模型排名

搜索大模型插件通过模型服务将AI能力集成到Elasticsearch集群中,实现语义向量搜索、语义排序等高级功能。其核心流程是基于业务需求(如语义搜索、智能推荐)定义模型类型(Embedding/Rerank等),并绑定对应的AI服务地址,确保上层应用能通过向量索引正确调用服务接口。

- 语义搜索:依赖Embedding模型服务,将文本转换为向量,实现相似性检索。

- 智能推荐:组合使用Embedding模型服务(生成用户/物品向量)和Rerank模型服务,优化推荐结果排序。

前提条件

确认Elasticsearch集群已启用搜索大模型插件,操作指导请参见开启搜索大模型插件。

支持的模型服务

搜索大模型插件支持接入多种模型服务,具体支持的模型服务清单如表1 支持的模型服务所示。

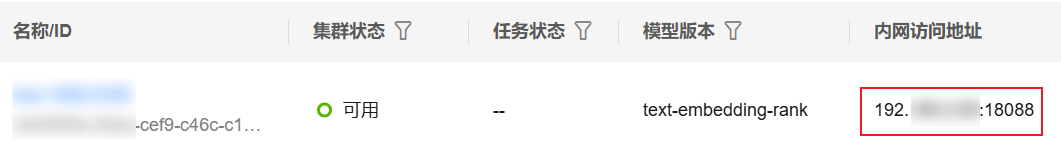

获取独享版集群的访问地址

- 登录 云搜索服务 管理控制台。

- 在左侧导航栏,选择“搜索大模型 > 独享版集群”。

- 在集群列表,选择目标集群,在“内网访问地址”列获取并记录集群的内网IP地址,后续配置模型服务需要使用。

一般是“<host>:<port>”或“<host>:<port>,<host>:<port>”样式。

图1 获取集群访问地址

登录Kibana

登录Kibana进入命令执行页面。Elasticsearch集群支持多种客户端访问,本文仅以 CSS 服务集成的Kibana为例介绍配置指导。

- 登录 云搜索 服务管理控制台。

- 在左侧导航栏,选择“集群管理 > Elasticsearch”。

- 在集群列表,选择目标集群,单击操作列的“Kibana”,登录Kibana。

- 在Kibana左侧导航栏选择“Dev Tools”,进入操作页面。

控制台左侧是命令输入框,其右侧的三角形图标为执行按钮,右侧区域则显示执行结果。

配置模型服务

当模型创建完成后,根据业务需要配置模型服务。下面介绍了各类模型服务的配置指导。

配置Embedding模型服务

在Kibana中执行以下命令,配置Embedding模型服务。其中,模型类型必须是semantic_vector。

PUT _inference/model_service/{service_name} { "description": "搜索大模型-语义向量化", "service_config": { "semantic_vector": { "service_urls" : ["http://{endpoint}/app/search/v1/vector"], "algorithm": "GRAPH", "metric": "inner_product", "dimension": "768", "timeout_ms": 30000 } } }

|

参数 |

是否必选 |

参数类型 |

描述 |

|---|---|---|---|

|

service_name |

是 |

String |

模型服务的名称。自定义,如pangu_vector。 |

|

service_urls |

是 |

List<String> |

访问模型服务的接口URL。 支持配置多个访问地址,用逗号分隔。 配置格式:http://{endpoint}/app/search/v1/vector,endpoint参考获取独享版集群的访问地址获取。 举例:http://192.168.0.85:18088/app/search/v1/vector |

|

method |

否 |

String |

模型服务的访问方法。 由Embedding模型服务决定,搜索大模型使用的是POST,保持默认值即可。 取值范围:POST、GET、PUT 默认值:POST |

|

algorithm |

否 |

String |

模型服务支持的向量索引算法。 取值范围:

默认值:GRAPH |

|

metric |

否 |

String |

计算向量之间距离的度量方式。 取值范围:

默认值:inner_product |

|

dimension |

否 |

String |

向量数据维度。 由Embedding模型服务决定,必须配置为768,保持默认值即可。 取值范围:1~4096 默认值:768 |

|

timeout_ms |

否 |

int |

访问模型服务的超时时间,超时会请求失败。 单位:ms(毫秒) 最小值:3000 默认值:10000 |

|

content_length |

否 |

int |

模型服务支持单个文档属性的最大值,超过最大值将进行文本截断。 默认值:-1(小于0代表不进行长度截断) |

|

embedding_type |

否 |

String |

配置Embedding模型的查询类型。

取值范围:

默认值:query2doc |

配置Rerank模型服务

在Kibana中执行以下命令,配置Rerank模型服务。其中,模型类型必须是reorder。

PUT _inference/model_service/{service_name} { "description": "搜索大模型-精排模型", "service_config": { "reorder": { "service_urls": ["http://{endpoint}/app/search/v1/rerank"], "timeout_ms": 60000 } } }

|

参数 |

是否必选 |

参数类型 |

描述 |

|---|---|---|---|

|

service_name |

是 |

String |

模型服务的名称。自定义,如pangu_ranking。 |

|

service_urls |

是 |

List<String> |

访问模型服务的接口URL。 支持配置多个访问地址,用逗号分隔。 配置格式:http://{endpoint}/app/search/v1/rerank,endpoint参考获取独享版集群的访问地址获取。 举例:http://192.168.0.85:18088/app/search/v1/rerank |

|

method |

否 |

String |

模型服务的访问方法。 由Rerank模型服务决定,搜索大模型使用的是POST,保持默认值即可。 取值范围:POST、GET、PUT 默认值:POST |

|

timeout_ms |

否 |

int |

访问模型服务的超时时间,超时会请求失败。 单位:ms(毫秒) 最小值:3000 默认值:10000 |

|

content_length |

否 |

int |

模型服务支持单个文档属性的最大值,超过最大值将进行文本截断。 默认值:-1(小于0代表不进行长度截断) |

管理模型服务

搜索大模型插件深度集成Kibana命令行界面(CLI),支持对模型服务进行更新、监控、扩缩容等全生命周期管理。如表4所示,可以通过标准CLI命令执行更新(update)、删除(delete)等核心操作管理模型服务。

|

操作类型 |

API命令 |

请求示例 |

响应示例 |

|---|---|---|---|

|

更新模型服务 |

POST _inference/model_service/{service_name}/update |

更新Embedding模型服务: POST _inference/model_service/pangu_vector/update

{

"description": "搜索大模型-语义向量化模型更新",

"service_config": {

"semantic_vector": {

"service_urls": ["http://{endpoint}/app/search/v1/vector"],

"timeout_ms": 60000

}

}

} |

返回更新后的模型服务信息: {

"service_name" : "pangu_vector",

"service_type" : "remote",

"description" : "搜索大模型-语义向量化模型更新",

"create_time" : 1747966388508,

"service_config" : {

"semantic_vector" : {

"embedding_type" : "query2doc",

"service_urls" : [

"http://{endpoint}/app/search/v1/vector"],

"method" : "POST",

"timeout_ms" : 60000,

"max_conn" : 200,

"security" : false,

"dimension" : "768",

"algorithm" : "GRAPH",

"metric" : "inner_product"

}

}

} |

|

检查模型服务连通性 |

GET _inference/model_service/{service_name}/check |

检查Embedding模型服务的连通性: GET _inference/model_service/pangu_vector/check |

{

"acknowledged" : true

} |

|

查看模型服务 |

|

查看Embedding模型服务的配置信息: GET _inference/model_service/pangu_vector |

返回模型服务信息: {

"count" : 1,

"model_service_configs" : [

{

"service_name" : "pangu_vector",

"service_type" : "remote",

"description" : "搜索大模型-语义向量化模型",

"create_time" : 1747966388508,

"service_config" : {

"semantic_vector" : {

"embedding_type" : "query2doc",

"service_urls" : ["http://{endpoint}/app/search/v1/vector"],

"method" : "POST",

"timeout_ms" : 60000,

"max_conn" : 200,

"security" : false,

"dimension" : "768",

"algorithm" : "GRAPH",

"metric" : "inner_product"

}

}

}

]

} |

|

删除模型服务配置(删除后,索引将无法使用该模型服务) |

DELETE _inference/model_service/{service_name} |

删除Embedding模型服务配置: DELETE _inference/model_service/pangu_vector |

{

"acknowledged" : true

} |

|

设置模型服务的数量上限(最多支持创建几个模型服务) |

PUT _cluster/settings

{

"transient": {

"pg_search.inference.max_inference_model_service": 100 //最大值是1000,最小值是1,默认值是100。

}

} |

设置模型服务的数量上限为10: PUT _cluster/settings

{

"transient": {

"pg_search.inference.max_inference_model_service": 10

}

} |

{

"acknowledged" : true,

"persistent" : { },

"transient" : {

"pg_search" : {

"inference" : {

"max_inference_model_service" : "10"

}

}

}

} |

ai模型排名常见问题

更多常见问题 >>-

模型转换,即将开源框架的网络模型(如Caffe、TensorFlow等),通过ATC(Ascend Tensor Compiler)模型转换工具,将其转换成昇腾AI处理器支持的离线模型。

-

盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合,重塑千行百业,成为各组织、企业、个人的专家助手。

-

近年来越来越多的行业采用AI技术提升效率、降低成本,然而AI落地的过程确并不容易,AI在具体与业务结合时常常依赖于业务数据的采集、处理、模型训练、调优、编排、部署和运维等很多环节。华为云ModelArts是全流程AI开发平台,包含了AI应用的开发、部署和分享交易,通过解决AI开发各个环节所遇到的核心问题,ModelArts有效解决了AI落地难的问题,将极大促进AI技术的普惠。本议题将分享ModelArts的主要关键技术和应用案例。

-

ModelArts是一个一站式的开发平台,能够支撑开发者从数据到AI应用的全流程开发过程。包含数据处理、模型训练、模型管理、模型部署等操作,并且提供AI Gallery功能,能够在市场内与其他开发者分享模型。

-

AI一站式开发平台ModelArts横空出世,零基础AI开发人员的福音。学习本课程,带你了解AI模型训练,不会编程、不会算法、不会高数,一样可以构建出自己专属的AI模型。

-

随着边缘设备数量指数级增长,以及设备性能的提升,数据量爆发式增长,数据规模已由原来的EB级扩展到ZB级。数据回传中心云处理成本太高,边缘计算的价值已经被证明。数据在哪,计算就应在哪,人工智能正逐步向边缘迁移,将云上AI能力下沉到边缘节点,做到本地处理,打通AI的最后一公里。虽然边缘AI技术的相关研究和应用都有着显著的进展,然而在成本、性能、安全方面仍有诸多挑战:

更多相关专题

增值电信业务经营许可证:B1.B2-20200593 | 域名注册服务机构许可:黔D3-20230001 | 代理域名注册服务机构:新网、西数