AI开发平台MODELARTS-GP Ant8裸金属服务器使用Megatron-Deepspeed训练GPT2并推理:Step3 单机多卡训练

时间:2024-04-30 19:22:38

Step3 单机多卡训练

和单机单卡训练相比, 单机多卡训练只需在预训练脚本中设置多卡参数相关即可, 其余步骤与单机单卡相同。

- 当前选择GPU裸金属服务器是8卡, 因此需要调整如下参数:

GPUS_PER_NODE=8

- 调整全局批处理大小(global batch size)、微批处理大小(micro batch size)、数据并行大小(data_parallel_size)参数。三者的关系为:“global_batch_size”可被“micro_batch_size * data_parallel_size”整除。

本文设置的参数值如下:

global_batch_size = 64 micro_batch_size = 4 data_parallel_size = 8

- 单机多卡完整的预训练脚本内容如下:

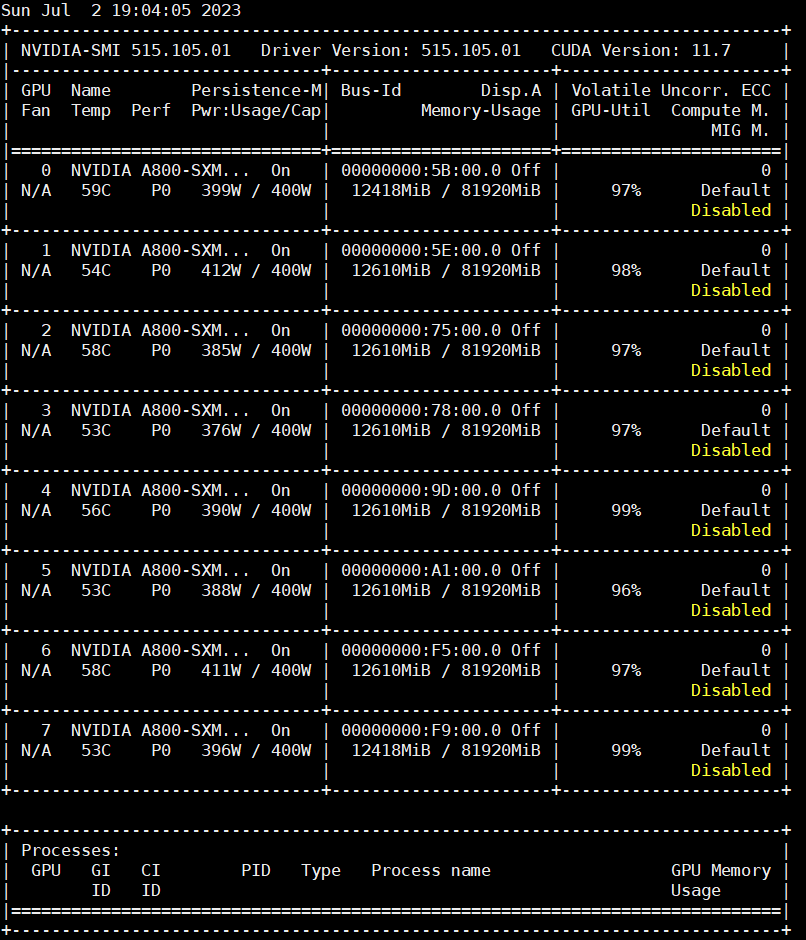

#! /bin/bash # Runs the "345M" parameter model GPUS_PER_NODE=8 # Change for multinode config MASTER_ADDR=localhost MASTER_PORT=6000 NNODES=1 NODE_RANK=0 WORLD_SIZE=$(($GPUS_PER_NODE*$NNODES)) DATA_PATH=data/meg-gpt2_text_document CHECKPOINT_PATH=checkpoints/gpt2 DISTRIBUTED_ARGS="--nproc_per_node $GPUS_PER_NODE --nnodes $NNODES --node_rank $NODE_RANK --master_addr $MASTER_ADDR --master_port $MASTER_PORT" python -m torch.distributed.launch $DISTRIBUTED_ARGS \ pretrain_gpt.py \ --tensor-model-parallel-size 1 \ --pipeline-model-parallel-size 1 \ --num-layers 24 \ --hidden-size 1024 \ --num-attention-heads 16 \ --micro-batch-size 4 \ --global-batch-size 64 \ --seq-length 1024 \ --max-position-embeddings 1024 \ --train-iters 5000 \ --lr-decay-iters 320000 \ --save $CHECKPOINT_PATH \ --load $CHECKPOINT_PATH \ --data-path $DATA_PATH \ --vocab-file data/gpt2-vocab.json \ --merge-file data/gpt2-merges.txt \ --data-impl mmap \ --split 949,50,1 \ --distributed-backend nccl \ --lr 0.00015 \ --lr-decay-style cosine \ --min-lr 1.0e-5 \ --weight-decay 1e-2 \ --clip-grad 1.0 \ --lr-warmup-fraction .01 \ --checkpoint-activations \ --log-interval 10 \ --save-interval 500 \ --eval-interval 100 \ --eval-iters 10 \ --fp16训练时监控的GPU利用率如下:

图7 GPU利用率

support.huaweicloud.com/usermanual-modelarts-lite/usermanual-modelarts-lite-0087.html

看了此文的人还看了

CDN加速

GaussDB

文字转换成语音

免费的服务器

如何创建网站

域名网站购买

私有云桌面

云主机哪个好

域名怎么备案

手机云电脑

SSL证书申请

云点播服务器

免费OCR是什么

电脑云桌面

域名备案怎么弄

语音转文字

文字图片识别

云桌面是什么

网址安全检测

网站建设搭建

国外CDN加速

SSL免费证书申请

短信批量发送

图片OCR识别

云数据库MySQL

个人域名购买

录音转文字

扫描图片识别文字

OCR图片识别

行驶证识别

虚拟电话号码

电话呼叫中心软件

怎么制作一个网站

Email注册网站

华为VNC

图像文字识别

企业网站制作

个人网站搭建

华为云计算

免费租用云托管

云桌面云服务器

ocr文字识别免费版

HTTPS证书申请

图片文字识别转换

国外域名注册商

使用免费虚拟主机

云电脑主机多少钱

鲲鹏云手机

短信验证码平台

OCR图片文字识别

SSL证书是什么

申请企业邮箱步骤

免费的企业用邮箱

云免流搭建教程

域名价格

推荐文章

下载AI开发平台MODELARTS用户手册完整版

下载AI开发平台MODELARTS用户手册完整版